سیستم های تشخیص گفتار به همراه کد

مقدمه

گفتار برای بشر طبیعی ترین و کارآمدترین ابزار مبادله اطلاعات است.

کنترل محیط و ارتباط با ماشین بوسیله گفتار از آرزوهای او بوده است.

طراحی و تولید سیستم های تشخیص گفتار هدف تحقیقاتی مراکز بسیاری در نیم قرن اخیر بوده است.

یکی از اهداف انسانها در تولید چنین سیستم هایی مسلماً توجه به این نکته بوده است که ورود اطلاعات به صورت صوتی، اجرای دستورات علاوه بر صرفه جویی در وقت و هزینه ،به طرق مختلف کیفیت زندگی ما را افزایش می دهند.

امروزه دامنه ای از نرم افزارها (که تحت عنوان سیستم های تشخیص گفتار[1] معرفی می شوند) وجود دارند که این امکان را برای ماا فراهم کرده اند.

با استفاده از این تکنولوژی می توانیم امیدوار باشیم که چالش های ارتباطی خود را با محیط پیرامون به حداقل برسانیم.

یکی از کاربردهای اصلی اینگونه نرم افزارها بعنوان واسط بین انسان و رایانه است از آنجائیکه خیلی از کارهای بوسیله ارتباطات بصری بهتر حل می شود، گفتار هم دارای این توانایی است که یک نوع رابطه بهتر از صفحه کلید باشد مخصوصاً برای کارهایی که بصورت ارتباط زبان طبیعی هستند و یا بجای آن دسته از صفحه کلیدهایی که مناسب یک کار خاص نیستند بسیار مفید است کاربرد سیستم تشخیص گفتار شامل آن دسته از اعمال که در آنها چشم و دست مشغول هستند نیز می شود مانند مکانهایی که کاربر مجبوراست با دست عملی را انجام دهد یا تجهیزاتی را کنترل نماید (مانند کنترل پرواز برای خلبان یک هواپیما یا هنگام عمل جراحی یک پزشک متخصص).

ناحیه کاربردی دیگر که هم اکنون ازسیستم تشخیص گفتار استفاده می شود در تلفن است بعنوان مثال برای وارد کردن اعداد، تشخیص کلمه « الو» برای پذیرش تماس و .. سرانجام سیستم تشخیص گفتار در دیکته عملی شد که عبارتست از سخنرانی طولانی یک شخص ویژه.

این کاربرد هم در مکانهایی مثل دادگاهها و مکانهایی که نیاز به ثبت گفتگوهای طولانی دارند عملی شد و کاربرد بسیار مهم دیگر آن فناوری تشخیص هویت شخص گوینده و کنترل امنیتی برای ورود به قلمروهای اطلاعاتی محرمانه و دسترسی از راه دور به کامپیوترهای می باشد.

این فنآوری امکان تشخیص هویت شخص گوینده و در نتیجه امکان کنترل دسترسی او در هنگام استفاده از خدماتی همانند شمارهگیری صوتی، بانکداری تلفنی، خرید تلفنی، خدمات دسترسی به پایگاه دادهها، خدمات اطلاعاتی، پست الکترونیکی صوتی، کنترل امنیتی برای ورود به قلمروهای اطلاعاتی محرمانه و دسترسی از راه دور به کامپیوترها را فراهم میآورد.

علاوه بر موارد فوق که عموماً با کامپیوتر و کاربران آن سروکار دارند این فنآوری در مسائل قضایی نیز کاربردهای خاص خود را دارد.

تکنولوژی تشخیص گفتار یکی از پیچیده ترین تکنولوژیهاست که با وجود تلاش بسیاری از دانشمندان در سالهای گذشت هنوز کمی و کاستی هایی دارد.

هوش مصنوعی که یکی از گرایشات مهندسی کامپیوتر است بر روی اعمال مهم و خارق العاده و در عین حال ساده موجودات زنده متمرکز شده است و با الهام گرفتن از آنها سعی در حل مسائل بشر می کند با توجه به کاربردهای سیستم تشخیص گفتار که در بالا ذکر شد حتماً متوجه اهمیت موضوع شده اید ولی ایجاد چنین سیستمی احتیاج به سطح علمی و فکری بسیار بالایی دارد و با مباحث مهمی مانند پردازش سیگنال دیجیتال، پردازش صوت، آشنایی با قواعد زبانی و شکل شناسی، شبکه های عصبی، قواعد احتمالاتی، پردازش زبان طبیعی و … در ارتباط می باشد.

اهمیت موضوع یاد شده از یک سو و تازگی آن از سوی دیگر ما را بر آن داشت تا با راهنمایی استاد محترم جناب آقای مهندس یزدانجو موضوع پروژهی پایانی خود را مطالعه بر روی این گونه سیستمها و طراحی یک نمونه کوچک سیستم تشخیص گفتار وابسته به متن به عنوان نتیجهی عملی و این نوشتار به عنوان فراهم آورندهی پیشزمینههای علمی و توصیفکنندهی نحوهی عملکرد آن میباشد.

نکته اساسی:

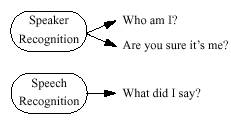

قبل از پرداختن به به سیستم های تشخیص گفتار لازم است که فناوری تولید گفتار و تشخیص گفتار با تعریفی ساده از هم متمایز شوند:

● فناوری تولید گفتار[2]: تبدیل اطلاعاتی مثل متن یا سایر کدهای رایانه ای به گفتاراست.

مثل ماشین های متن خوان برای نابینایان، سیستم های پیغام رسانی عمومی. سیستم های تولید گفتار به خاطر سادگی ساختارشان زودتر ابداع شدند.

این نوع از فناوری پردازش گفتار موضوع مورد بحث در این پروژه نیستند.

● فناوری تشخیص گفتار[3]: نوعی فناوری است که به یک کامپیوتر این امکان را می دهد که گفتارو کلمات گوینده ای را که از طریق میکروفن یا پشت گوشی تلفن صحبت می کند، بازشناسی نماید.

به عبارت دیگر در این فناوری هدف خلق ماشینی است که گفتار را به عنوان ورودی دریافت کند و آنرا به اطلاعات مورد نیاز (مثل متن) تبدیل کند.

فصل اول: تعاریف– ضرورت ها – کاربردها

-

- تاریخچه فناوری تشخیص گفتار

اولین سیستم های مبتنی بر فناوری تشخیص گفتار در سال 1952 در”آزمایشگاههای بل” طراحی شد.

این سیستم به شیوه گفتار گسسته و به صورت وابسته به گوینده و با تعداد لغت محدود 10 لغت عمل می کرد.

در اوایل دهه 80 میلادی برای اولین بار الگوریتم مدلهای مخفی مارکوف[4] ارائه شد.اینن الگوریتم گامی مهم در طراحی سیستم های مبتنی بر گفتار پیوسته به حساب می آمد.

همچنین در طراحی این سیستم از مدل شبکه عصبی و نهایتاًً ازهوش مصنوعی نیز استفاده می شود.

در ابتدا شرکتهای تجاری این فناوری را برای کاربردهای خاصی طراحی کردند.

به عنوان مثال شرکت کورزویل[5] درر زمینه پزشکی و مخصوصاً برای کمک به معلولان و نابینایان و شرکت دراگون[6] در زمینه خودکارسازی سیستمهای اداری محصولات اولیه وارد بازارکردند.. توانجویان در واقع اولین گروهی بودند که از این دسته محصولات به عنوان یک فناوری انطباقی و یاریگر، عمدتاً برای دو عملکرد کنترل محیط و واژه پردازیی استفاده کردند.

جیمز بیکر[7] یکی از محققان شرکت IBM که در اواخر دهه 1970 در مورد این فناوری مقالات زیادی نوشت، یکی از پیشگامان این طرح بود.

او و همکارانش یک شرکت خصوصی به نام سیستم های دراگون[8] تاسیس کردند.

این شرکت ابتدا در دهه 1990 نرم افزاری به نام دراگون دیکتیت[9] تولید کرد که یکک سیستم مبتنی بر گفتار گسسته بود.

در سال 1997 این شرکت محصولی را تولید کرد که به جای استفاده از گفتارگسسته ،مبتنی بر گفتار پیوسته بود.

در واقع این شرکت با ارائه نرم افزار (DNS)[10] اولین سیستم تشخیص گفتار پیوسته را ارائه نمود.

این سیستم توانایی تشخیص گفتار با سرعت 160 کلمه درر دقیقه را داشت.

همچنین شرکت تجاری IBM هم در این زمینه برای سالهای متمادی فعالیت می کرد که با طراحی بسته نرم افزاری Via Voice به ارائهه سیستم های تشخیص گفتار پرداخت که در حال حاضر اسکن سافت[11] محصولات IBM Via Voice راتوزیع و پشتیبانی می کند.

شرکت مایکروسافت نیزز فعالیتهایی درجهت تولید و کاربرد این فناوری داشته است، و بیل گیتس[12] در کتابها و سخنرانی هایش به کرات در مورد آینده درخشان استفاده ازز سیستم های تشخیص گفتار تاکید کرده است.

البته عملاً تا قبل از ارائه نرم افزار آفیس XP [13] و ورد 2002[14] این تکنولوژی در محصولات این شرکتت بکاربرده نشد.

گرچه در ابتدا عمده موارد استفاده این تکنولوژی ،برای افراد توانجو پیش بینی شده بود اما بعدها پذیرش استفاده از آن گسترده تر شد وو گروههای بسیاری در مدارس و دانشگاهها علاقه مند به استفاده ازاین فناوری شدند.

بطوریکه دانشگاه استون هال[15] نیز برای تشویق دانشجویان بهه آشنایی با این سیستم به دانجشویان جدید الورود نرم افزار IBM Via Voicee را اهدا می کرد.

1-2- کاربردهای سیستم های تشخیص گفتار

ارزش ایجاد فنآوریهای تشخیص گفتار بسیار زیاد است.

صحبت سریعترین و کاراترین روش ارتباط انسانهاست.

ورود اطلاعات به صورت صوتی، اجرای دستورات علاوه برصرفه جویی در وقت و هزینه، به طرق مختلف کیفیت زندگی ما را افزایش می دهند.

و می تواند پتانسیل جایگزینی مناسبی برای نوشتن، تایپ، ورود صفحهکلید و کنترل الکترونیکی و اجرای دستورات توسط کلیدها و دکمهها اعمال میشود را داراست و امروزه دامنه ای از این نرم افزارها تحت عنوان سیستم های تشخیص گفتار[16] وجود دارند که این امکان را برای ما فراهم کرده اند.

با استفاده از این تکنولوژی می توانیم امیدوارر باشیم که چالش های ارتباطی خود را با محیط پیرامون به حداقل برسانیم.

و همانگونه که مشخص است توانايي سيستم در شناسايي گفتار و انواع آنن مي تواند کاربردهاي بسيار و در عين حال جالبي داشته باشد.

تشخیص صحبت فقط نیاز به آن دارد که کمی برای پذیرش توسط بازار تجاری بهتر کار کند. از جمله اين کاربردها مي توان به موارد زیر اشاره کرد:

1-2-1- استفاده از این تکنولوژی برای دیکته کردن و ایجاد مدرک:

از آنجایی که تایپ کامپیوتری از کارهای متداول و وقت گیربرای کاربرهای عادی و پیشرفته می باشد بنابراین اولین موارد استفاده از این تکنولوژی، تایپ کامپیوتری بوده است که باعث افزایش سهولت و سرعت تایپ می شده است مثل کاربرد این سیستم برای روزنامه نگاران و حقوقدانان.

رونویسی سخنرانی طولانی یک شخص ویژه (مکان دادگاهها و مکان هایی که نیاز به ثبت گفتگوهای طولانی عملی شد.) این امر به ویژه زمانی که افراد ملزم به تایپ مکرر هستند اهمیت پیدا می کند زیرا بیماری سندرم کانال مچی[17] که یکی از انواع آسیب های ناشی از تکرار می باشد در اثر استفاده تکرارر شونده از کیبورد برای تایپ پدید می آید.

با استفاده از سیستم های تشخیص صدا و تایپ با کیبورد به طور همزمان می توان از بروز اینگونه آسیب هاا جلوگیری کرد.

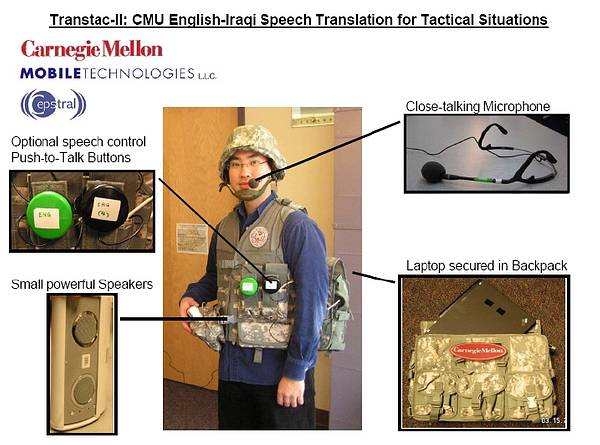

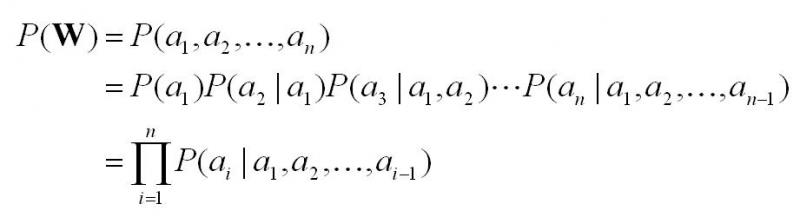

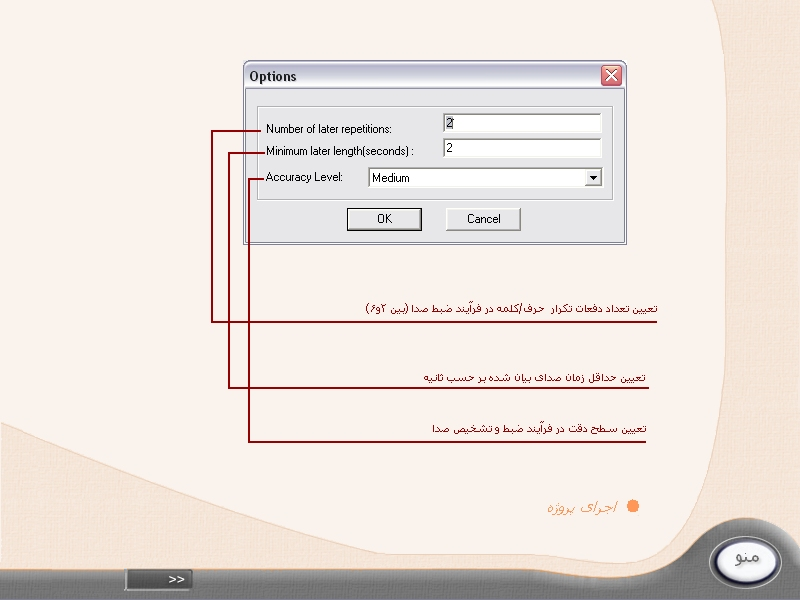

شکل1-1

همچنین افراد توانجو یا کسانی که به هر نحو قادر به تایپ کردن نمی باشند، می توانند خود را با این سیستم ها تطبیق دهند و از آنها بطور موثری استفاده کنند(به عنوان مثال افرادی که قادر به استفاده از دستان خود نیستند،یا از لحاظ بینایی دچار مشکل هستند).

حتی گزارش شده است که استفاده از یک نرم افزار تشخیص صدا به یک مرد مبتلا به بیماری “زبان پریشی” کمک کرده است که بتواند عقایدش را در قالب زبان نوشتاری بیان کند و با اطرافیان خود ارتباط برقرار کند.

1-2-2- استفاده از این نرم افزار برای ترجمه زبانها:

یکی از آژانس های پروژه های تحقیقاتی پیشرفته دفاعی آمریکا دارای سه تیم از محققانی است که بر روی GALE [18] که برنامه ای که اطلاعات روزنامه ها و اخبار پخش شده در زبانهای خارجی را ترجمه می کند،کار می کنند.

این پروژه امیدوار است که بتواند نرم افزاری ایجاد کند که بتواند دو زبان را باا حداقل 90 درصد دقت به یکدیگر ترجمه کند.

این آژانس همچنین بر روی یک پروژه تحقیقی و توسعه به نام TRANSTAC سرمایه گذاری کرده است که سربازان ایالات متحده امریکا را قادر می کند به شکل موثرتری با جمعیت غیر نظامی کشورهای غیر انگلیسی زبان به تعامل بپردازند.

شکل1-2

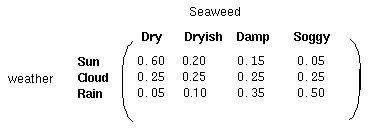

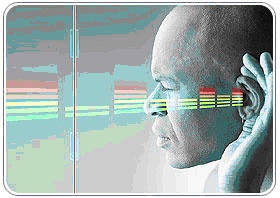

1-2-3- فناوری تشخیص گفتار در راهبری سیستم های اطلاعاتی مالی و امنیتی

این فناوری به لحاظ ویژگی نهفته در آن یعنی اطلاعات یکتای موجود در موج صوتی صحبت هر فرد که احتمال مشابهت در افراد به صفر یا عددی نزدیک به آن است. مهمترین اساس برای طراحی سیستم های امنیتی وابسته به فرد خاص مورد استفاده قرار گرفته است.

شکل1-3

شکل1-3

این فنآوری امکان تشخیص هویت شخص گوینده و در نتیجه امکان کنترل دسترسی او در هنگام استفاده از خدماتی همانند شمارهگیری صوتی، بانکداری تلفنی، خرید تلفنی، خدمات دسترسی به پایگاه دادهها، خدمات اطلاعاتی، پست الکترونیکی صوتی، کنترل امنیتی برای ورود به قلمروهای اطلاعاتی محرمانه و دسترسی از راه دور به کامپیوترها را فراهم میآورد.

1-2-4- استفاده در مکتوب کردن مستندات صوتي

به استفاده در نگارش اخبار و صورت جلسه ها ،استفاده در مکتوب کردن مستندات صوتي، ارسال فرامين صوتي، کاهش حجم داده ها و در نتيجه افزايش پهناي باند در مخابره گفتار و همچنين تنظيم متون و نامه هاي متني به کمک گفتار نام برد.

آنچه که مشخص است انسان تمايل دارد مستقيما گفتار را بصورت مکتوب تبديل نمايد و از وارد کردن نوشتار اجتناب نمايد.

از خصوصيات اینگونه سيستم می توان به توانايي شناسايي گفتار از دو منبع متفاوت، به صورت بلادرنگ از ميکروفن و يا تبديل فايل صوتي به متن، قابليت استفاده در محيطهاي متفاوت، امکان آموزش با گفتار کاربر، قابليت شناسايي تمام واژگان مصطلح در زبان فارسي (اعم از کلمات بيگانه) نام برد. انجام پروژه متلب

1-2-5- استفاده از فناوری تشخیص گفتار برای جایی که کاربر می تواند با ادا کردن دستورات آنها را انجام دهد:

تقریباً اولین گروهی که به استفاده از این فناوری روی آوردند، خلبانان بودند.

خلبانان در اتاقک پرواز با استفاده از این سیستم ها علاوه کمک به کنترل امور پرواز بدون نیاز به دست، استرس ناشی از پرواز را کاهش می دادند.

همچنین استفاده از این فناوری درحوزه های مشابه مانند فضا نوردی و هوانوردی نیزآزمایش شده است.

علاوه بر این توانجویان به طور وسیع این فناوری را به عنوان ابزاری برای کنترل محیط و انطباق بیشتر با آن بکار بردند.

به عنوان مثال توانجویان حرکتی قادر خواهند بود با کمک این فناوری دستورات حرکتی به صندلی چرخدار خود بدهند.

یا حتی در ایده ال ترین وضعیت به کمک کار گذاشتن تراشه های هوشمند و سازگار با فناوری تشخیص صدا در عضو مصنوعی به دست و پای مصنوعی خود فرمانهای حرکتی متنوع صادرکنند.

1-2-6- استفاده از فناوری تشخیص گفتار در پزشکی :

استفاده از کامپیوتر را برای کلیه افراد ناتوان بدنی که دارای توانایی شنوایی و گفتاری مناسب هستند را آسان می کند به عنوان یک وسیلهی خروجی کاربرپسند در محیطهای مختلف میتواند با جایگزین کردن بسیاری از علائم دیداری (انواع چراغها و…) و شنوایی (انواع زنگهای اخطار و …) با گفتارهای بیان کنندهی کامل پیامها استفاده و رسیدگی به سیستمهای نیازمند این گونه پیامها را بهینه کند.

و موارد بیشمار کاربرد این فناوری در پزشکی به چشم می خورد.

1-2-7- ساده سازي ارتباط با سيستم گفتار تلفني

امروزه تلفن و سيستم هاي تلفني جزيي جدا نشدني از زندگي همه افراد است.

علاوه بر ايجاد ارتباطات مختلف گفتاري، در مرورگرهاي صوتي، سيستم هاي ارتباط با مشتري و IVR ها به شکل گسترده اي در شرکتها و ادارات به کار گرفته مي شوند.

با وجود کاربردهاي فراوان اين سيستم ها، محدوديت هاي مختلفي مانند نياز به پخش پيغام راهنماهاي زياد، سختي کار با تعداد بالاي انتخاب ها و مبتني بر تن بودن آنها در برخي کاربردها محدودتر کرده است.

اضافه کردن تشخيص خودکار گفتار، يکي از طبيعي ترين راه حل هاي رفع اين محدوديت هاست.

شکل1-5

تشخيص گفتارتلفني علاوه بر آسان ترکردن ارتباط مشتري با موسسات و مراکز مربوطه، کاهش هزينه و ارائه بهتر سرويس ها را به مشتريان به دنبال دارد.

اين قابليت به سادگي محاوره با اين سيستم ها و حل بيشتر مشکلات و محدوديت هاي آنها منجر مي شود.

تعدادي از نسخه هاي مختلف توسعه داده شده براي تشخيص گفتار تلفني به صورت زير است:

– منشي خودکار تلفني مبتني بر گفتار

– تشخيص اعداد و فرامين صوتي از پشت تلفن

– سيستم IVR تلفني مبتني بر گفتار براي بانکها

– تلفن گوياي اطلاع رساني سازمان ها، بهداشت و قرآن با قابليت تشخيص گفتار

دقت تشخيص بالاي 96 درصد، سرعت تشخيص بالا، پشتيباني از زبانهاي انگليسي و فارسي و کار با رابطهاي تلفني موجود مانند مودم و برد دیالاجیک[19] از ويژگي هاي منحصربه فرد اين سيستم ها هستند.

1-2-8- کاربرد فناوری تشخیص گفتار در کتابخانه

سیستم های تشخیص گفتار آنچنان که در حوزه های دیگر مثل پزشکی و انجمن های حقوقی مورد استفاده قرار گرفتند در کتابخانه ها بکار گرفته نشده اند و کتابخانه ها بیشتر موضعی منفعلانه نسبت به بکارگیری این فناوری از خود نشان داده اند.

اما با توجه به ماهیت خدمات کتابخانه ای و همچنین تنوع کاربرانی که تمایل به استفاده ازکتابخانه دارند مطمئناً وجود چنین فناوری کمک فراوانی به کتابداران در تسریع و بهبود خدمات کتابخانه ای می کند.

به عنوان مثال در کارهای خدماتی – فعالیت هایی که کتابدار به یک ابزار ارتباطی غیر از چشم ها و دست ها نیاز دارد- مثل رف خوانی و فهرست نویسی پیوسته، ویا در فعالیتهای مربوط به سرویسهای کتابخانه ای مثل بازیابی اطلاعات و کنترل فرایند امانت، و نهایتاً در ایجاد امکان دسترسی به پایگاه های اطلاعاتی از راه دور می تواند کاربرد موثری داشته باشد.

همچنین با استفاده از اینگونه سیستم ها می توان به نمایه سازی چند رسانه ای ها (مانند فیلم و ویدئو) پرداخت که دراین حالت کلمات کلیدی در قالب گفتار وارد می شوند و به صورت گفتارنیز بازیابی می شوند.

از سوی دیگر با ورود این فناوری به کتابخانه ها و فعالیتهای آن می توان انتظار داشت که کاربران کتابخانه بطور چشمگیری افزایش یابند، چرا که همیشه کاربرانی هستند که نمی توانند با سیستم معمول کتابخانه کار کنند و از منابع اطلاعاتی آن استفاده کنند.

این گروه کاربران می توانند کم سوادان و یا طیف وسیعی از توانجویان باشند که در صورت بکارگیری این فناوری آنها نیز با امکان دسترسی به منابع، جزوکاربران همیشگی کتابخانه ها می شوند.

1-2-9- استفاده از این فناوری برای تشخیص اعداد که بصورت گفتاری بیان شده باشند

مورد استفاده در بسیاری از کاربردها از جمله اعلام شماره شناسائی شخصی، شماره حساب بانکی، یا شماره عضویت برای کاربران یک سیستم خدمات رسانی، ارتباط با بانک اطلاعاتی از راه دور، ثبت نام دانشجویان از طریق تلفن یا اینترنت و مانند آن بسیار حائز اهمیت است.

البته توجه به این نکته که موارد بالا فقط گوشه ای از کاربردهای وسیعی این فناوری بر زندگی بشر دارد اهمیت ویژه ای دارد.

1-3- عملکرد سیستم های تشخیص گفتار

سیستم های تشخیص گفتار به هر منظور که بکار برده شوند، عملکرد نسبتاً مشابهی دارند که عبارت است از:

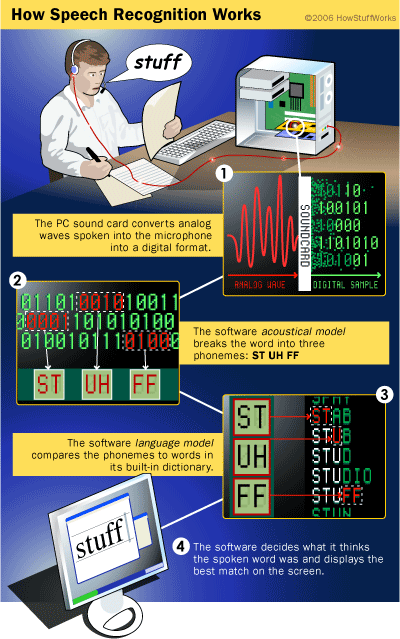

شکل -16

تبدیل گفتاربه داده

برای تبدیل گفتار به یک متن روی صفحه یا یک فرمان کامپیوتری، یک سیستم باید راه دشواری را طی کند.

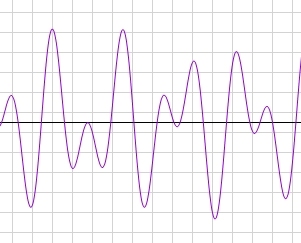

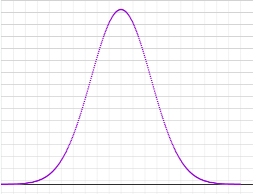

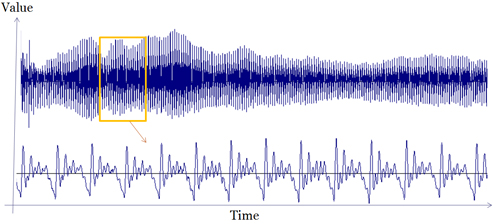

وقتی که گوینده صحبت می کند، لرزشهایی در هوا ایجاد می شود، سیستم تشخیص گفتار ابتدا امواج صوتی آنالوگ را دریافت می کند، مبدل آنالوگ به دیجیتال (ADC)[20] این امواج آنالوگ را به دادهه های دیجیتالی تبدیل می کند.

سپس سیگنال به سگمنت های کوچکی که به اندازه چند صدم ثانیه یا در مورد صامت های بی صدا[21] چند هزارم یکک ثانیه هستند، تقسیم می شود.

در مرحله بعد برنامه این سگمنت ها را به واج[22] های شناخته شده در زبان تبدیل می کند.

واج ،کوچکترین عنصریک زبانن است (ارائه ای از صداهایی که ما می سازیم و برای شکل دادن واژه های معنی دار آنها را در کنار هم قرار می دهیم).

گام بعدی ساده به نظر می رسدد اما در واقع انجام آن بسیار دشوار است.

برنامه واج های موجود را با سایر واج هایی که درکنار آن قرار دارد، امتحان می کند و واج های هم بافت را از طریق یک مدل آماری بسیار پیچیده نقطه[23] می کند و آنها را با مجموعه بزرگی متشکل از واژه های شناخته شده، عبارات و جملات مقایسه می کند.

برنامه سپس چیزی را که کاربر احتمالاً گفته است مشخص می کند و آن را به عنوان متن یا شکل یک فرمان کامپیوتری یا صوت بیرون می دهد.

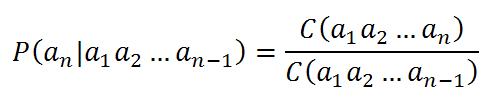

تشخیص گفتار با استفاده از مدل(الگوریتم)آماری

سیستم های تشخیص گفتار اولیه سعی داشتند مجوعه ای از قوانین گرامری و دستوری را با گفتار ورودی منطبق کنند.

به این صورت که اگر کلمه های گفته شده در داخل مجموعه ای از قواعد و قوانین جای می گرفتند و با آن سازگار می شدند، برنامه می توانست کلمه را تشخیص دهد.

تنوع لهجه ها ونوع گفتار افراد مختلف در این حالت از تشخیص می توانست تاثیر منفی بر روی دقت این سیستم ها بگذارد.

به عنون مثال تلفظ کلمه برن[24] توسطط فردی از بوستون و لندن متفاوت است در حالی که هر دو یک لغت را بکار برده اند.

سیستم ها مبتنی بر قواعد و قوانین دستوری به این دلیل موفق نبودندد که نمی توانستند گفتار ممتد را با حداقل میزان اشتباه تشخیص دهند.

سیستم های تشخیص گفتار امروزی از سیستم های مدل آماری بسیار قدرتمند و پیچیده ای استفاده می کنند.

این سیستم ها از قواعد احتمالات وریاضی برای تشخیص نتیجه استفاده می کنند.

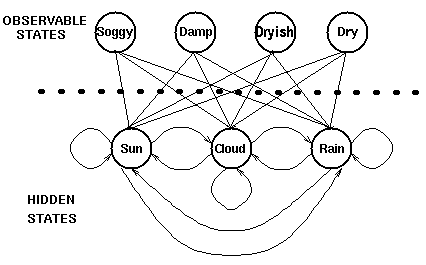

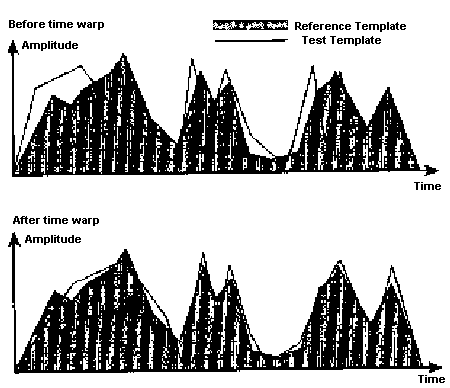

دو مدل مسلط امروز در این حوزه مدل مخفی مارکوف[25] و مدل شبکه عصبی[26] هستند.

این روشها اساساً برای مشخص کردن اطلاعات پنهان از سیستم، از اطلاعاتی که برای سیستم شناخته شده هستند استفاده می کنند.

مدل مخفی مارکوف رایجج ترین مدل است.در این مدل هر واج مثل یک پیوند در یک زنجیره است و هنگامی این زنجیره تکمیل می شود، یک کلمه بوجود می آید.

در طی این فرایند، برنامه یک امتیاز[27] احتمالاتی را بر اساس دیکشنری توکار و آموزش کاربر به هر واج اختصاص می دهد.

این فرایند برای عبارات و جملات، حتی از این همم پیچیده تر است. (سیستم مجبور است مشخص کند که هر کلمه کجا شروع می شود و کجا به اتمام می رسد).

گاهی برنامه ناچار است عباراتی را کهه شنیده است را با عبارت یا عبارت های قبل ار آن که در بافت جمله هستند مقایسه کند، آن را تجزیه و تحلیل کند تا بتواند آنرا به درستی تشخیص دهد.

بنابراین اگر یک برنامه دارای 60000 کلمه باشد ترتیبی از سه کلمه می تواند هر یک از 216 تریلیون احتمال ممکن باشد.

بدیهی است که حتی قدرتمندترین سیستم هم نمی تواند بدون کمک، تمام این احتمالات را جستجو کند.

این کمک به شکل”آموزش”برنامه ارائه می شود.

با وجود اینکه توسعه دهندگان و طراحان نرم افزار که دستگاه واژگانی اصل سیستم را تنظیم می کنند، بخش اعظمی از این آموزش را انجام می دهند اما کاربر نهایی نیز باید زمان زیادی را صرف این آموزش کند.

1-4- انواع سیستمهای تشخیص گفتار

1-4-1- تقسیم بندی بر اساس عملکرد

فناوری تشخیص گفتار بر اساس سه معیارقابل بررسی و طبقه بندی است:

تعداد گویندگان

همانطور که قبلاً نیز اشاره شد، درونداد اطلاعات در این سیستم به صورت صوتی-گفتار انسان- است.

بسته به اینکه سیستم برای استفاده تعداد محدودی گوینده طراحی شده باشد یا نه، این سسیستم به دو دسته “وابسته به گوینده” و “مستقل از گوینده” تقسیم می شوند.

در سیستم های وابسته به گوینده، سیستم هر صدایی را تشخیص نمی دهد بلکه فقط صداهایی که قبلاً آنها را آموزش دیده است را تشخیص می دهد.

بدین صورت که شخص با ایجاد یک پروفایل صوتی از صدای خود، صدای خود را به سیستم آموزش می دهد و سیستم نیز با مراجعه به این پروفایل بار دیگر آن را تشخیص می دهد.این سیستم ها دقیق ترند.

اما سیستم های مستقل از گوینده طوری طراحی می شوند که سیستم قادر باشد هر نوع صدایی را تشخیص دهد.

شیوه صحبت کردن

نحوه صحبت کردن گوینده می تواند به دو صورت “گفتار گسسته” و یا “گفتار پیوسته” باشد.

در سیستم های مبتنی بر گفتار گسسته گوینده کلمات را جدا جدا و با مکث حداقل 200 میلی ثانیه بین آنها ادا می کند تا سیستم کلمات را بصورت مجزا تشخیص دهد.

در این نوع از سیستم بانک واژگان شامل کلماتی است که برای سیستم از قبل تعریف شده است.

وقتی که سیستم مبتنی بر گفتار پیوسته باشد، مرز کلمات گوینده واضح نیست که در این صورت برای انطباق گفتار با بانک واژگان، بانک واژگان از “واجهای” زبان تعریف شده تشکیل شده است.

اندازه بانک واژگان

اندازه بانک واژگان، از نظر واژگان ذخیره شده در سیستم ” محدود” و یا “بزرگ” است.

که بین نوع سیستم از نظر وابستگی به گوینده و اندازه بانک واژگان رابطه معکوس وجود دارد.

در سیستم های وابسته به گوینده اندازه بانک واژگان بزرگ و تعداد کاربر کم است.

این نوع سیستم ها که معمولا در محیط های تجاری بکار گرفته می شوند و تعداد کمی کاربر با این برنامه کار می کنند به بهترین نحو ممکن جوابگو هستند.

در حالی که این سیستم ها با سطح دقتی مناسب کار می کنند و دارای هزاران کلمه هستند باید طوری تنظیم شوند که با تعداد کوچکی از کاربران اصلی کار کنند و میزان دقت این سیستم ها تا حد بسیار زیادی به کاربر بستگی دارد.

در سیستم هایی که مستقل از گوینده عمل می کنند،تعداد کاربران زیاد است اما تعداد واژاگان اندک است.

در این سیستم ها کاربران می توانند با لهجه ها و الگوهای گوناگون تلفظ صحبت کنند هرچند، استفاده از این سیستم ها محدود به تعداد اندکی از فرامین و ورودی های از پیش تعریف شده نظیر گزینه های ابتدایی و اعداد است.

1-4-2- سیستم های تشخیص گفتار: تقسیم بندی بر اساس برونداد

سیستم های تشخیص گفتار همگی در یک ویژگی مشترک هستند و آن “لزوم درونداد به صورت صوتی” در این گونه سیستم هاست.

این سیستم ها را بر اساس بروندادی که ارائه می کنند می توانیم به سه دسته تقسیم بندی کنیم:

الف.سیستم های گفتار به متن[28]

ب. سیستم های گفتار به گفتار[29]

ج.سیستم های گفتار به فرامین[30]

که در ادامه هریک به طور مختصر معرفی می شوند.

گفتار به متن

این دسته از سیستم ها توانایی تبدیل گفتار به متن یا تشخیص خودکار گفتار را دارند.

از این تکنولوژی برای “دیکته کردن و ایجاد مدرک” استفاده می شود.

از آنجایی که تایپ کامپیوتری از کارهای متداول و وقت گیر برای کاربرهای عادی و پیشرفته می باشد بنابراین اولین موارد استفاده از این تکنولوژی، تایپ کامپیوتری بوده است که باعث افزایش سهولت و سرعت تایپ می شده است مثل کاربرد این سیستم برای روزنامه نگاران و حقوقدانان.

برخی نرم افزارها در زیر برای این نوع سیستم ها معرفی می شوند:

شکل 1-8

- IBM Via Voice [31]: تنها نرم افزاری است که سیستم عامل لینوکس را پشتیبانی می کند.

- نرم اقزار مدل مخفی مارکوف می یر[32]: نرم افزاری است که توسط ریچارد می یر با الگوی HMM نوشته و طراحی شده است و برای کاربران حرفه ای کاربرد دارد.

- فناوری استفاده شده در ویندوز ویستا، فناوری استفاده شده در ویندوز XP که در قالب برنامه های ورد و ورد 2002 به بعد، ارائه شده است.

- نرم افزار دیکته خودکار فارسی/انگلیسی نویسا

- یک نرم افزار تشخیص گفتار به دو زبان فارسی و انگلیسی بدون وابستگی به گوینده است که توسط گروه SPl [33] در دانشگاه صنعتی شریف طراحی و تولید شده است. کاربرمی تواند از این نرم افزار در هر ویرایشگری در محیط ویندوز استفاده کند.

گفتار به گفتار

سیستم های گفتار به گفتار شامل استفاده از فناوری تشخیص گفتارعمدتاً در تولید نرم افزارهای ترجمه گفتار به گفتار می باشد.

شرکت Via یک مترجم زبانی را توسعه داده است که در اختیار انگلیسی زبانان قرار گرفته است که البته این محصول در تعداد انبوه وارد بازارنشده است.

نام این ابزار که نوعی سخت افزار است، “ابزار مترجم جهانی Via II” می باشد، وسیله ای است به اندازه یک گوشی تلفن با عملکرد PC که به کمر کاربر متصل می شود یا در جیب لباس وی قرار می گیرد.

Via II با یک نرم افزار تشخیص صدا سازگار است و با داشتن در گاه USB حتی امکان اتصال به ادوات جانبی را هم دارا است.

این ابزار با قدرت شناسایی مجموعه گسترده ای از زبانها نظیر کره ای، صربستانی، عربی، تایلندی، چینی،و… ارائه می شود.

این سیستم برای کاربران انگلیسی زبان طراحی شده است که قادر است صدای کاربر را شناسایی کندو به زبان مقصد ترجمه کندو از طریق بلندگو پخش کند و همچنین در مدت زمان کوتاهی قادر است که پاسخ فرد مخاطب را به انگلیسی ترجمه کند که به این ترتیب یک ترجمه دو طرفه انجام می شود.

شکل1- 9

موارد بالا نمونه هایی از تلاش محققان جهان برای توسعه این فناوری بودند.

در ایران و برای کاربران فارسی زبان نیز “نرم افزار پارسیا” طراحی و تولید شده است که یک نرم افزار ترجمه صوتی(گفتار به گفتار) زبان فارسی است و عبارات رایج و مکالمات روزمره فارسی را به زبانهای مقصد (انگلیسی و عربی) ترجمه می کند.

این نرم افزار توسط گروه SPL دانشگاه صنعتی شریف طراحی و تولید شده است.

گفتار به دستور

از این نوع فناوری برای کنترل برنامه ها[34] استفاده می شود.

با استفاده از این فناوری کاربر می تواند با ادا کردن دستورات آنها را انجام دهد.

شکل 1-10

با استفاده از این فناوری کاربر می تواند با گفتن جملات دستوری مانند” فایل را باز کن” یا “صفحه راببند” برنامه های مختلف کامپیوتری رانیزکنترل کند.

از این فناوری به همراه قابلیت تبدیل گفتار به متن در برخی سیستم های عامل استفاده شده است.

برخی از نرم افزارها در زیر آورده شده اند:

- C Voice Control [35]: در سیستم عامل لینوکس استفاده می شود و امکان اجرای دستورات را بوسیله فرامین صوتی فراهم می کند.

- کامندر گیم[36]: برنامه ای است مستقل از گوینده و بدون نیاز به آموزش که با ایجاد فرمانهای صوتی برخی بازی های مشهور ویندوز را کنترل می کند.

1-5- نمونه هایی از نرم افزارهای تشخیص گفتار طراحی و پیاده سازی شده :

نرم افزارهایی که در این زمینه ارائه شده بسیار زیاد می باشد که اگر به ذکر همه موارد بپردازیم شاید به صدها مورد برسد ولی در اینجا به چند نمونه خیلی کاربردی از این نرم افزارها که خوشبختانه اکثر آنها در ایران طراحی و ساخته شده اشاره می کنیم تا به اهمیت، وسعت و کاربرد این نرم افزارها پی ببریم:

1-5-1- طراحی و پیاده سازی سیستم نرم افزار فناوري بازشناسي گفتار توسط جمعي از متخصصين دانشگاه صنعتي شريف در زمينه پردازش گفتار (شيوهاي بسیار جديد براي تشخيص پيام ها و دستورهاي صوتي)

شکل1-11

عنوان طرح: فناوري بازشناسي گفتار مقاوم در برابر نويز

توضيح عمومي و كاربرد: با استفاده از اين فناوري، صداي ضبط شده توسط يك ميكروفون، بازشناسي شده و به فرامين براي يك دستگاه الكترونيكي يا رايانه، تبديل مي شوند. حوزه كاربرد اين فناوري، تمامي دستگاه هاي الكتريكي، الكترونيكي و رايانه اي است كه به طريقي از كاربر فرمان مي گيرند. تمام فرامين قابل بيان با استفاده از مجموعه متناهي كلمات گسسته را مي توان با استفاده از اين فناوري، توسط ميكروفون به دستگاه يا رايانه داد.

مزايا در مقايسه با ديگر فناوري هاي مشابه: مهم ترين خصوصيات اين فناوري، نياز به توان پردازشي بسيار كم و مقاومت بسيار زياد در مقابل سرو صداي محيط (نويز) است.

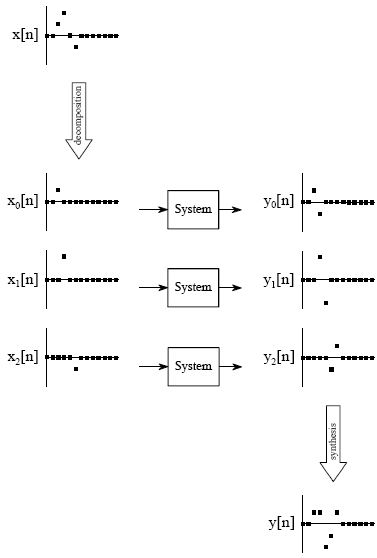

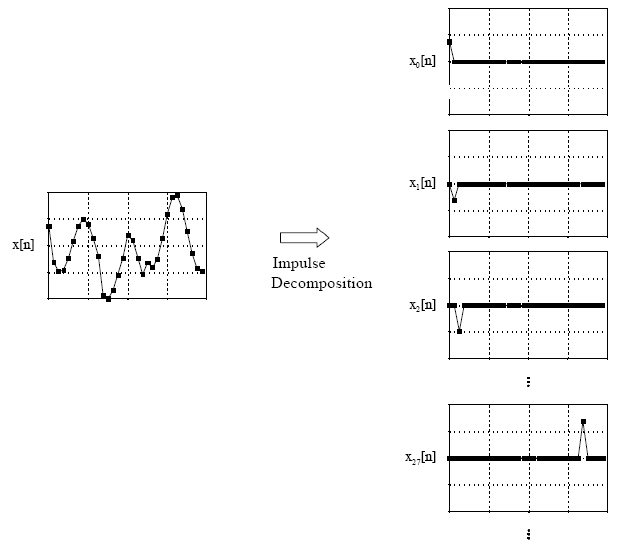

شرح طرح: روش ارائه شده، از سه بخش اصلي تشكيل شده است: 1. بخش اول كه وظيفه تبديل سيگنال صوتي به دادههاي قابل پردازش را براي دو بخش ديگر انجام ميدهد. 2. بخش دوم كه وظيفه يادگيري و توصيف كلمات را برعهده دارد و با گرفتن نمونههاي ضبط شده كلمات، الگوهاي لازم براي بخش بازشناسي را ميسازد. 3. بخش سوم كه دادههاي گرفته شده از بخش اول را با الگوهايي كه در بخش دوم ياد گرفته شدهاند، مقايسه ميكرده و شبيهترين كلمه را انتخاب ميكند.

از قابليت هاي این طرح آن است که از لحاظ سخت افزاري كوچك و از نظر هزينه مقرون به صرفه می باشد. ويژگي هاي منحصربه فرد اين طرح، آن را از جديدترين فناوري هاي موجود دنيا در زمينه پردازش گفتار، متمايز مي سازد.

از جمله ويژگي هاي اين طرح مي توان به موارد زير اشاره كرد:

قابل اجرا بر روي رايانه يا سخت افزاري مستقل، سهولت استفاده، هزينه اندك پياده سازي، عدم وابستگي به هيچ نوع زبان يا گويشي. عدم حساسيت به سروصداي محيط، امكان تعريف دستورهاي صوتي، مطابق با سليقه كاربرفناوري بازشناسي گفتار، برپايه اين ويژگي ها در طيف گسترده اي از محصولات قابل استفاده است. نمونه هايي از زمينه هاي كاربرد آن عبارتند از: خودروها، لوازم خانگي الكتريكي و الكترونيكي، اسباب بازي ها، عروسك ها و سرگرمي هاي رايانه اي، سيستم هاي دستيار افراد كم توان و سالخورده، نرم افزارهاي رايانه اي مديريتي، سيستم هاي آموزش زبان بهعنوان نمونه، از اين نرم افزار در دادن فرامين صوتي به خودرو بويژه هنگامي كه راننده مشغول رانندگي است و نمي تواند كار دستی ديگري انجام دهد، استفاده مي شود. فرامين صوتي شامل موارد ذيل مي شوند:

- تنظيم آينه هاي بغل و عقب 2. كنترل بالابر شيشه ها 3. كنترل قفل كودك 4. كنترل روغن ترمز و موتور يا بنزين در حال حركت 5. كنترل راديو يا هر نوع رسانه ديگر در خودرو 6. كنترل برف پاك كن ها 7. تنظيم صندلي ها 8. كنترل چراغ ها 9. هر نوع دستور ديگر كه انجام آن نيازمند حركت اضافي راننده و يا سرنشينان است.

اين نرم افزار، به خوبي در محيط پر نويز، عمل مي كند. مثلا، در خودرويي با سرعت 100 كيلومتر در ساعت با شيشه هاي باز و در بزرگراه، تست شده و پاسخ مناسب گرفته است. ديگر مزيت اين نرم افزار، حجم بسيار پايين آن است كه به راحتي قابل برنامه ريزي بر روي يك IC است (نسخه دمو روي کامپیوترهای جیبی[37] به راحتي تا 100 فرمان را پردازش مي كند). نرم افزار مورد بحث، با اين مشخصات، در ايران مشابه ندارد و موارد موجود در دنيا نيزز مانند ویس کامند[38] در میکروسافت آفیس[39] ، حداقل نياز به پردازنده پنتیوم[40] با حجم زياد حافظه دارند. نكته ديگر اينكه اين نرم افزار، هوشمند بوده وو قابل آموزش دادن است و پس از آموزش (مثلا با صداي اعضاي يك خانواده) صداي هر كدام از آنها را كه بشنود (و در كل هر زماني كه كلمه يا فرمان راا بشنود) مستقل از اين كه چه كسي آن را ادا كرده است (صداي زن يا مرد، كلفت يا نازك) فرمان را اجرا مي كند.

1-5-2- سامانه هوش مصنوعی پارسه با نام تجاری (پایس) مشاور رباتیک (سیستم پیشرفته ترین سیستم هوش مصنوعی جهان)

مهندس مولوی مخترع و نابغه جوان ایرانی دانش فنی پیشرفته ترین هوش مصنوعی جهان را با عنوان سامانه پارسه تولید کرد و امسال در فینال مسابقات جام جهانی رایانه در کشور چین با شکست مایکروسافت، آی.بی.ام، ناسا و کمپانی های بزرگ دنیا توانست مقام نایب قهرمانی را پس از اینتل کسب کند. در نخستین بار حضور ایران در مسابقات جام جهانی اختراعات رایانه ای و رقابت با کمپانی های بزرگ و غول های رایانه ای جهان همچون میکروسافت، اینتل، IBM و دانشگاه های بلند آوازه جهان توانسته است پس از گذراندن 4 مرحله مقدماتی، طرح برتر قاره، طرح برتر 3 قاره و نیمه نهایی به فینال این رقابت ها راه پیدا کند و پس از پشت سر گذاشتن طرح هایی مانند: سیستم کنترل تمام هوشمند ایستگاه بین المللی فضایی آژانس تحقیقات فضایی آمریکا (Nasa)، یک طرح از مایکروسافت، بمب هوشمند رباتیکی ارتش فیلیپین، صفحه مانیتور کریستالی با قطر یک برگ کاغذ کمپانی LG و سیستم خبره هوشمند پزشک فوق تخصص برای همه بیماری ها کمپانی فیلیپس مقام نایب قهرمانی را کسب کند. این سیستم پیشرفته ترین سیستم هوش مصنوعی جهان است این سیستم در مقام مشاور شهردار تهران می باشد. و شهردار تهران نخستین شهردار در کشورهای جهان است که از پیشرفته ترین سیستم هوش مصنوعی در دنیا بهره خواهد برد. این سیستم قابلیت ها و توانمندی های زیادی دارد که از آن جمله می توان به این ویژگی های منحصر به فرد اشاره کرد: اطلاعات و آمار و ارقام ده ها متخصص، دانشمند و کارشناس شهرداری را یکجا و به صورت همزمان و آنلاین ارائه کند و در اختیار بگذارد، شهردار نیز با یک میکروفون اطلاعات لازم را از آن بخواهد. از سوی دیگر، قرار است این سیستم به سامانه 137 شهرداری نیز سوئیچ و متصل شود و به نحوی آن را هوشمند کند، به این ترتیب جای تمام کسانی را که در این حوزه کار پاسخگویی را انجام می دهند، بگیرد. این سامانه توانایی گرفتن اطلاعات از شهروندان و پاسخگویی به آنها را دارد و از طرف دیگر به طور مستقیم آن را در اختیار شهردار قرار می دهد این سیستم هوشمند یا همان سامانه پارسه در حقیقت به عنوان مغز کنترل کننده شهر الکترونیکی و مجازی تهران وارد عمل خواهد شد. به عبارت بهتر پایه و بنیان اولیه شهر مجازی و الکترونیکی تهران که مغز کنترل کننده هوشمند آن است در حال حاضر آماده و راه اندازی شد و شهردار با رایانه متصل به این سیستم هوشمند همانند یک انسان می تواند صحبت کند و اطلاعات را بگیرد. سامانه هوش مصنوعی پارسه با نام تجاری (پایس) یک نرم افزار رایانه ای مبتنی بر فناوری هوش مصنوعی است که با داشتن قابلیت های خاص و منحصر به فرد توانسته است بسیاری از آرزو های بشر در زمینه رویای هوش مصنوعی و رباتیک را تا حد بالایی به واقعیت تبدیل کند. این سامانه که با بهره گیری از زبان های مختلف برنامه نویسی نوشته شده است، توانایی درک گفتار طبیعی انسان را به فارسی و انگلیسی و به صورت کاملا محاوره ای، تولید گفتار به زبان های فارسی و انگلیسی (سخن گفتن)، شناسایی گوینده و تصدیق هویت گوینده از روی گفتار، قابلیت دستور پذیری و انجام کامل تمامی دستورات و اعمال در محیط رایانه (سیستم عامل های ویندوز) را با استفاده از گفتار محاوره ای به زبان های فارسی و انگلیسی، امکان گفت وگو با یک تصویر که می تواند حتی تصویر خود کاربر باشد و سامانه به صورت خودکار آن را پویانمایی و به صورت هماهنگ با گفتار به حرکت در خواهد آورد، قابلیت تصمیم گیری و انتخاب مبتنی بر الگو و دانش قبلی، قابلیت استنتاج و استدلال مبتنی بر دانش، قابلیت یادگیری، قابلیت تشخیص و حذف نویز های مخرب در سیگنال گفتار، امکان تایپ گفتاری متون به فارسی و انگلیسی، قابلیت کار در محیط تمامی نرم افزار ها و بازی های رایانه ای بدون محدودیت و به صورت کاملا گفتاری و آن هم به صورت گفتار محاوره ای معمولی را در قالب یک نرم افزار جامع فراهم کرده است. برای مثال کاربرد این سامانه نرم افزاری روی رایانه بدین گونه است که هنگامی که شما این نرم افزار را روی سیستم خود نصب می کنید، می توانید بدون استفاده از صفحه کلید و موس با رایانه کار کنید؛ بدین صورت که شما با گفتار محاوره ای و بسیار معمولی(همانگونه که در طول روز با دیگران صحبت می کنید، البته با در نظر گرفتن اینکه سیستم نمی تواند اصطلاحات شما را متوجه شود) می توانید با رایانه کار کنید. بدین معنا که مثلا برای باز کردن برنامه فتوشاپ فقط کافی است که به سیستم بگویید فتوشاپ روباز کن! تا این عمل انجام شود. البته سیستم های دستور دهی صوتی در جهان بسیار کار شده اند، اما تفاوت این سامانه با آنها این است که در آن سیستم های گذشته نمی توان گفت که کل سیستم به صورت گفتار کار می کند بلکه آنها مثلا در بازی های رایانه ای و یا محیط داخلی نرم افزار ها عمل نمی کردند ولی سامانه هوش مصنوعی پارسه کاملا و می توانم بگویم به طور قطعی صفحه کلید و موس را از رایانه حذف می کند. مزیت بارز دیگر این سیستم در این است که درصد تشخیص گفتار آن بسیار بالا و خطای آن بسیار پایین است و تقریبا تمامی گفتار شما را متوجه می شود. همچنین شما می توانید با آن به طور محاوره ای و معمولی سخن بگویید و سیستم به طور هوشمند متوجه خواسته شما خواهد شد. همچنین در این سیستم شما می توانید با تصویر پویانمایی شده یک صورت صحبت کنید، درد دل کنید، از آن مشاوره بخواهید و همچنین به آن دستور بدهید تا آن هم با شما صحبت کند و عکس العمل نشان دهد. سیستم می تواند سیگنال گفتار شما را شناسایی و شما را تشخیص هویت کند و بسیاری از قابلیت های دیگر که باعث کاربردی تر شدن آن در رایانه می شود. برای مثال اگر شما می خواهید در رایانه متنی را تایپ کنید کافی است به رایانه دستور دهید که مثلا زودباش برنامه ورد را باز کن. یا مثلا بگویید می خواهم یک متن را تایپ کنم. تا سیستم آماده تایپ شود و سپس شما متن خود را بخوانید تا سیستم آن را تایپ کند و در آخر آن را غلط گیری کنید و دستور چاپ آن را بدهید؛ این یک نوع عملکرد این سیستم است و بسیاری از کاربردها و قابلیت های دیگر و مهم این سیستم آن است که سامانه هوش مصنوعی پارسه به دلیل برخورداری از قدرت انتخاب، تصمیم گیری، استدلال و استنتاج و همچنین بازشناسی الگو و به طور عامیانه استفاده از تجربه قبلی می تواند به عنوان یک سیستم هوشمند در هواپیما، اتومبیل، سیستم های فضایی، و… به عنوان کنترل کننده جایگزین انسان گردد. همچنین نصب این سیستم بر روی تلویزیون با موفقیت صورت پذیرفت. تلویزیون های هوشمند طرح پارسه می توانند بدون وجود ریموت کنترل و فقط به صورت گفتاری کنترل شوند، می توانند با شما گفت وگوکنند و با شما صحبت کنند و همچنین شما می توانید تصویر صورت خود را به وسیله یک حافظه فلش به تلویزیون بدهید تا سیستم به طور خودکار آن را پویا نمایی و سخنگو کند و شما بتوانید با آن عکس صحبت کنید.

1-5-3- نرم افزار مترجم صوتی گفتار به گفتار زبان فارسی پارسیا:

این نرم افزار تشخیص گفتار مستقل از گوینده، امکان ترجمه مستقیم گفتار فارسی به گفتار معادل در زبان های انگلیسی و عربی فراهم شد. (مهندس باقر بابا علی، دانشجوی دکتری کامپیوتر دانشگاه صنعتی شریف و مدیر بخش تحقیقات شرکت SPL دانشگاه صنعتی شریف سازنده این نرم افزار) درباره کاربردهای نرم افزار افراد می توانند بدون دانستن زبان خارجی نیازهای ابتدایی خود را برآورده کنند. برای مثال برای پرسیدن ساعت صبحانه، مراکز خرید، یک رستوران خوب یا قیمت لباس می توان به زبان فارسی صحبت کرد و رایانه بعد از درک کلمه، معادل آن در زبان مقصد را بیان می کند. جنبه دیگر این نرم افزار کمک به آموزش زبان و یادگیری عبارات مورد استفاده در مکالمات روزمره است . در مترجم صوتی گفتار به گفتار «پارسیا» جملات و عبارات بیان شده توسط کاربر مستقیما به گفتار معادل در زبان های انگلیسی و عربی ترجمه و بیان می شود تا به زبان مورد نظر ترجمه شود. در نسخه جاری این نرم افزار گفتار فارسی مستقیما به گفتار معادل در زبانهای انگلیسی و عربی ترجمه می شود. ویژگی و هسته اصلی این مترجم، یک سیستم تشخیص خودکار گفتار فارسی است که گفتار کاربر را پردازش کرده و آن را تشخیص می دهد، سپس گفتار تشخیص داده شده به معادل خود در زبان مقصد برگردانده می شود. این ویژگی «پارسیا» را به عنوان اولین نرم افزار فارسی با قابلیت تشخیص گفتار از همه نرم افزارهای دیگر متمایز می کند. این نرم افزار در دو نسخه قابل نصب نسخه روی pc و قابل نصب کامپیوترهای جیبی (pda) توسعه داده شده است .

1-5-4- نرم افزار نویسا:

متخصصان شرکت تحقیقات دانشگاه شریف با دستیابی به فن آوری طراحی و ساخت نرم افزار تشخیص گفتار مستقل از گوینده، نرم افزاری نیز برای تایپ گفتار فارسی طراحی کرده اند که قادر است گفتار کاربران را که از طریق میکروفن به رایانه منتقل می شود به در محیط ورد، نت پد[41] یا هر صفحهه ویرایشی که امکان تایپ فارسی در آن وجود دارد، بنویسد.

از کاربردهای جانبی این سیستم – علاوه بر استفاده به جای تاپیست -، استفاده توسط پزشکان جهت تهیه گزارش یا نسخه ی دارو، نوشتن اسناد حقوقی توسط وکلا یا تایپ سایر متون تخصصی در زمینه های مختلف است که در این راستا نسخه تخصصی نرم افزار نویسا (تایپ گفتاری) به منظور استفاده متخصصان قلب در نوشتن نسخه توسعه داده شده که این قبیل نمونه های تخصصی نرم افزار به دلیل اختصاصی بودن و کاهش دامنه کلمات از دقت و کارایی به مراتب بالاتری برخوردارند.

مزیتهای استفاده از سیستم تایپ گفتاری نویسا:

صرفهجویی در زمان، کاهش هزینه، افزایش سرعت تایپ و ورود اطلاعات، حفظ امنیت اطلاعات در هنگام ورود دادهها، قابلیت استفاده در بسیاری از سیستمهای (مستندسازی، ترجمه گفتاری و …)، جلوگیری از اشتباهات تایپی یک نسخه از این سیستم بر روی یک رایانه نصب میشود و میتواند با صدای کاربران آموزش داده شود. این سیستم دارای لوازم جانبی از جمله میکروفن ویژه تشخیص گفتار میباشد. این سیستم شامل نصب و آموزش در محل به صورت رایگان میباشد. سیستم شامل 18 ماه ضمانت و 5 سال خدمات پس از فروش میباشد. پشتیبانی سرویس دهنده تا 6 ماه رایگان میباشد اما پشتیبانی[42] ها شامل هزینه میباشد.

مشخصات و ویژگیهای سامانه تایپ گفتاری نویسا به صورت زیر است:

دقت تشخیص 95% در محیط اداری، تشخیص و تایپ متن به صورت بی درنگ، قابلیت تشخیص جملات به صورت طبیعی و پیوسته شامل حدود 21 هزار کلمه پر کاربرد زبان فارسی، دارای ویرایشگر ویژه جهت استفاده برای تایپ گفتاری و ویرایش راحتتر قابلیت استفاده در اغلب محیطهای تایپ رایج مانند میکروسافت ورد[43]، نت پد[44] و …، قابلیت استفاده در فرمها یا قسمتهایی که امکان تایپ فارسی دارند، قابلیت ویرایش متون در هنگام تایپ گفتاری یاا بعد از آن، امکان استفاده از تایپ برای کلمات خاص، لاتین یا عربی در هنگام استفاده از سیستم گفتاری، قابلیت اضافه نمودن کلماتی که در بانک کلماتت سیستم موجود نیستند (مانند اسامی خاص)، قابلیت تشخیص علایم خاص مانند نقطه، علامت سوال و علامت تعجب به صورت صوتی، علاوه بر اطلاعات آوایی، در این سیستم مشابه انسان، از اطلاعات زبانی مانند معنی و ترتیب کلمات برای فهم جمله بیان شده استفاده شده است. قابلیت تخصصی نمودن دایره کلمات برای کاربردهای خاص وجود دارد و کلمات تخصصی یا کلمات خاص به سیستم اضافه میشود. همچنین میتوان سیستم را با متنهای آن کاربرد خاص تطبیق نمود تا کارایی سیستم برای این منظور بهبود یابد. اختصاصی نمودن سیستم برای کاربردهای خاص مستلزم هزینه اضافی است که به هزینه سیستم اضافه میشود.

قابلیت تطبیق و آموزش به گوینده یا محیط خاص، استفاده از دستور زبان و سایر اطلاعات زبانی، راحتی و سادگی واسط گرافیگی کاربر، واسط کاربر دو زبانه (انگلیسی و فارسی)

1-5-5- نرم افزار مبتنی بر سیستم تشخیص گفتار پیوسته فارسی نرم افزار «نیوشا» :

شرکت عصر گویش پرداز نرم افزار تشخیص گفتار از پشت تلفن را طراحی و پیاده سازی کرده است استفاده از نرم افزار تشخیص گفتار تلفنی در موسسات و ادارات علاوه بر تسهیل ارتباط مشتری با آنها به کاهش هزینه و ارائه بهتر خدمات به مشتریان منجر می شود. این قابلیت به تسهیل محاوره و حل برخی از مشکلات مربوط به استفاده از سیستم های مبتنی بر «تن» منجر می شود. کار با تعداد کلمات زیاد، استفاده از تلفن های «پالس» و «تن» و جلوگیری از شماره گیری های وسط مکالمه از جمله مزیتهای دیگر این سیستمهاست. منشی خودکار تلفنی مبتنی بر گفتار، تشخیص اعداد فرامین صوتی از پشت تلفن، سیستم IVR تلفنی مبتنی بر گفتار برای بانک ها، سیستم اطلاع رسانی تلفنی مبتنی بر گفتار برای سازمان ها و تلفن های گویای «ندای سلامت» و «ندای قرآن» را از جمله نسخه های توسعه داده شده سیستم تشخیص گفتار تلفنی «نیوشا» عنوان کرد. سیستم های تشخیص گفتار طراحی شده دارای ویژگی های منحصر به فردی هستند، کارایی بالا در شرایط مختلف، سرعت تشخیص بالا، مستقل از گوینده بودن، پشتیبانی از زبان های فارسی و انگلیسی، قابلیت اضافه شدن به عنوان یک واحدمجزا به سیستم های تلفنی موجود و کار با رابطهای تلفنی موجود مانند مودم و برد دیالجیک را از جمله این ویژگی ها عنوان می شود .

1-5-6- [45] C Voice Control: در سیستم عامل لینوکس استفاده می شود و امکان اجرای دستورات را بوسیله فرامین صوتی فراهم می کند.

1-5-7- کامندر گیم[46]: برنامه ای است مستقل از گوینده و بدون نیاز به آموزش که با ایجاد فرمانهای صوتی برخی بازی های مشهور ویندوز را کنترل می کند.

1-5-8- IBM Via Voice[47] : تنها نرم افزاری است که سیستم عامل لینوکس را پشتیبانی می کند.

1-5-9- نرم افزار مدل مخفی مارکوف می یر[48]: نرم افزاری است که توسط ریچارد می یر با الگوی HMM نوشته و طراحی شده است و برای کاربران حرفه ای کاربرد دارد.

1-5-10- فناوری استفاده شده در ویندوز ویستا و ویندوز XP :که در قالب برنامه های ورد XP و ورد 2002 به بعد، ارائه شده است.

1-5-11- ابزار مترجم جهانی Via II : شرکت Via یک مترجم زبانی را توسعه داده است که در اختیار انگلیسی زبانان قرار گرفته است که البته این محصول در تعداد انبوه وارد بازارنشده است.این ابزار که نوعی سخت افزار است وسیله ای به اندازه یک گوشی تلفن با عملکرد PC که به کمر کاربر متصلل می شود یا در جیب لباس وی قرار می گیرد.Via II با یک نرم افزار تشخیص صدا سازگار است و با داشتن در گاه USB حتی امکان اتصال به ادوات جانبی را هم دارا است.این ابزار با قدرت شناسایی مجموعه گسترده ای از زبانها نظیر کره ای،صربستانی،عربی،تایلندی،چینی،و… ارائه می شود .این سیستم برای کاربران انگلیسی زبان طراحی شده است که قادر است صدای کاربر را شناسایی کندو به زبان مقصد ترجمه کندو از طریق بلندگو پخش کند و همچنین در مدت زمان کوتاهی قادر است که پاسخ فرد مخاطب را به انگلیسی ترجمه کند که به این ترتیب یک ترجمه دو طرفه انجام می شود.

1-5-12- فناوری تشخیص گفتاری برای کودکان

يکي از کاربرد هاي جالب موتور تشخيص گفتار، قابليت استفاده از آن توسط کودکان مي باشد. براي رسيدن به اين منظور شرکت عصر گويش پرداز اين موتور تشخيص را در قالب يک بازي سرگرم کننده براي کودکان مورد استفاده قرار داده است. ساختار اين نرم افزار در قالب يک داستان مي باشد که کودک به عنوان شخصيت اول آن (به اسم علي) در جريان بازي قرار مي گيرد. طي اين بازي کودکان بيش از 50 کلمه پرکاربرد زبان انگليسي را آموزش مي بينند و در کنار آن اطلاعات عمومي و روحيه همکاري نيز به او آموزش داده مي شود.

شکل 1-12

کاربرد موتور تشخيص گفتار در اين نرم افزار به اين صورت است که در طول بازي براي عبور از هر مرحله کودک بايد به تعدادي سوال از کلمات انگليسي اي که تا کنون ياد گرفته پاسخ درست بدهد. پاسخ دادن به اين سوالات به اين صورت است که جواب سوال به وسيله ميکروفوني که همراه اين نرم افزار عرضه مي شود بيان مي گردد و موتور تشخيص صحت آن را تشخيص مي دهد.

استفاده از قابليت تشخيص گفتار براي کودکان و اجراي آن در قالب بازي براي اولين بار روي زبان فارسي صورت گرفته است که اين مطلب باعث تمايز چشم گير اين نرم افزار از ساير نرم افزار هاي کودکان گرديده است. دقت بالاي تشخيص کلمات و قابليت انعطاف و راحتي کار با نرم افزار از مزيت هاي اين بازي هستند.

1-5-13- ساخت دستگاه هوشمند جهت جداسازی پسته های پوک از مغزدار با استفاده از پردازش صدا و شبکه های عصبی :

اجزای این دستگاه شامل جعبه صدا، میکروفن، نرم افزار پردازش سیگنال، مکانیسم انتقال و جداسازی پسته می باشد انعکاس صدای برخورد پسته با یک صفحه فولادی در حالت آف لاین[49] از دو ارتفاع برخورد 25 سانتیمتر و 35 سانتیمتری توسط سیستم خودکار استحصال داده توسط میکروفن جمع آوری وو به رایانه منتقل می شود سیگنال های صدای برخورد در دو حوزه زمان، فرکانس مورد پردازش قرار گرفته و در هر حوزه بردارها مشخصات مناسب استخراجج می شود از شبکه عصبی پرسپترون چند لایه جهت جداسازی استفاده شده است. این دستگاه پسته های پوک را دقت 93 درصد و پسته های مغزدار را با دقت 94 درصد جدا می سازند.

1-5-14- تلفنی که دستورات گفتاری کاربر را اجرا می کند:

تلفن همراه SPH-p207 ساخته شرکت سامسونگ دارای نرم افزاری تشخیص گفتار است که بر این اساس به پیام های گفتاری سریعتر از تایپ کردن آنها روی صفحه شماره گیری جواب می دهد.

وظیفه اصلی این تلفن بی سیم تبدیل گفتار انسان به سیگنال های دیجیتالی و بالعکس می باشد استفاده از دستورات گفتاری برای شماره گیری و کنترل سایر وظایف در بعضی از گوشی های گران قیمت متداول بوده است. اما تلفن SPH-p207 سامسونگ اولین تلفنی است که از فناوری تشخیص گفتار برای دیکته یک متن استفاده می کند. قیمت این گوشی 200 دلار است و با شرکت وایرلس سینگیولار[50] قرار داد دو ساله دارد .

1-5-15- دقت 99 درصدي نرمافزارهاي تشخيص صدا:

شركت اسكن سافت, نرم افزار جديد تشخيص صداي خود را با دقت بسيار بالاتر طراحی کرد نرمافزار تشخيص صدا را تحت عنوان[51]DNP8 به بازار عرضه كرد. اين شركت آمريكايي ادعا ميكند: نمونه جديد در ضبط صداي كاربر نسبت به نمونه قبلي 25 درصد دقيقتر عمل ميكند. شركت اسكن سافت, با ادعاي اينكه نرمافزار جديد در 99 درصد موارد صداي كاربران را به طور دقيق ضبط و پردازش ميكند، اعلام كرد: كاربران ميتوانند صداي خود را بر روي تنگستن[52] يا ديگر تجهيزات نظيرPC هاي جيبي و تجهيزات ضبط ديجيتالC ضبط كنند و بعد با انتقال آن به نرم افزار جديد اين شركت آن را به متن تبديلل كنند

-

-

- استفاده مایکروسافت از فناوری تشخیص گفتار:

-

این شرکت سال قبل شرکت نتورکس تل می[53] را خرید. حال با ترکیب فناوری تشخیص گفتار این شرکت با سرویس های موقعیت یاب جهانی (GPS) تحولی در این زمینه ایجاد کرده طوری که کاربران سرویس مذکور با گفتن کلمه «سینما» به نزدیک ترین سینمای محل حضورشان راهنمایی خواهند شد.. آنها می توانند فقط با گفتن نام فیلمی که خواستار دیدنش هستند، پیش از رسیدن به محل سینما بلیط آن رزرو کنند.

همچنین این شرکت فناوری تشخیص گفتار خودروی جدید شرکت فورد را نشان داد. در این خودرو می توان به جای دست با استفاده از گفتار، دستگاه پخش کننده موسیقی را کنترل کرد یا به دستگاه موقعیت یاب فرمان داد. همچنین می توان از طریق وصل کردن گوشی موبایل به ماشین به صورت بی سیم و از طریق بلوتوث، با گفتن نام هر یک افراد ثبت شده در دفترچه تلفن با او تماس برقرار کرد. این فناوری Sync نام دارد و تخمین می زنند که تا سال 2009 حدود یک میلیون ماشین دارای Sync را به فروش رسانده باشد.

1-6- ضعف ها و محدودیت های سیستم های تشخیص گفتار

هیچ برنامه تشخیص گفتاری که بتواند صددرصد درست عمل کند وجود ندارد، چندین عامل وجود دارند که می توانند میزان دقت این برنامه ها را کاهش دهند و یا استفاده از آنها را محدود کنند:

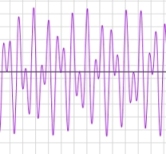

1-6-1- ورود سرو صدای محیط[54]

شکل1-13

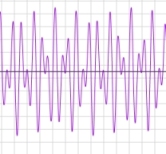

برنامه باید واژه هایی که ادا می شوند به طور واضح بشنود هرنوع صدای اضافی همزمان با صدای گوینده وارد شود می تواند با واجهای صوتی اشتباه گرفته شود و در این فرایند تداخل ایجاد کند. منبع ایجاد نویز می تواند بسیار گوناگون باشد. مثل نویز موجود در صدای پس زمینه دریک محیط اداری و شلوغ که برای حذف آنها درهنگام استفاده کاربران باید در یک مکان نسبتاً آرام مستقر شوند و از میکروفن با کیفیت (مثل میکروفونهای نویز پخ[55]) استفاده کنند و یا در هنگام صحبت میکروفن را در نزدیکی دهان خود قرار دهند.

گاهی نیز کارت های صوتی کیفیت پایین باعث کم شدن دقت سیستم می شوند این کارت ها اغلب فاقد لایه محافظ در برابر سیگنال الکتریکی ایجاد شده توسط سایر اجزای کامپیوتر هستند و می توانند صدای هوم یا هیس را به سیگنال (صوتی) وارد کنند.

امروزه با بکار گیری” نرم افزار بهبود کیفیت ” به همراه این فناوری تا حد زیادی سروصدای محیط و خش های اضافی قابل حذف شدن می باشد. این محصول می تواند هم به صورت نرم افزاری مستقل مورد استفاده قرار گیرد و هم به صورت یک امکان مجزا برای بهبود کیفیت گفتار و در نتیجه بهبود کارایی و دقت در نرم افزارهای دیگر بکار گرفته شود. این نرم افزار یکی از محصولات گروه SPL دانشگاه صنعتی شریف می باشد.

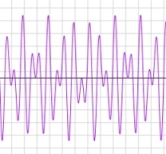

1-6-2- اثرگذاری کلمات بر یکدیگر و نحوه تلفظ آنها

شکل1-14

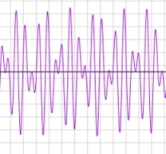

اثر گذاری کلمات بر روی همدیگر هنگام ادا شدن توسط گوینده ها وحتی حذف شدن واج های ابتدایی و انتهایی هنگام چسبیدن کلمات به هم کار تشخیص را مشکل می سازد. همچنین نحوه تلفظ کلمات توسط افراد مختلف و وجود لهجه های گوناگون بر دقت سیستم تاثیر می گذارند. در یک محیط کاری ،کاربران اصلی برنامه باید زمان نسبتاً زیادی را صرف صحبت کردن در سیستم کنند تا سیستم را با الگوی تلفظی خود آموزش دهند و آنرا با گفتار خود هماهنگ کنند. همچنین آنها باید سیستم را با واژه ها، اصطلاحات و کلمات مترادف ویژه ای که در آن محیط استفاده می کنند،آموزش دهند. نسخه های ویژه ای از برنامه های تشخیص صدا (که معمولاً وابسته به گوینده هستند) برای دفاتر قانونی یا مراکز درمانی وجود دارد که دارای واژه های مصطلح و رایجی که در این محیط ها بکار برده می شوند هستند.

1-6-3-کلمات متشابه[56]

کلمات مشابه واژه هایی هستند که از نظر تلفظ شبیه هم هستند اما از نظر معنی و ریشه و گاهی املا با هم فرق دارند.there ،their، air ،heir ؛ be و bee مثال هایی از این نوع کلمات هستند. هیچ راهی برای یک برنامه تشخیص صدا وجود ندارد که بتواند بطور دقیق تفاوت بین این واژه ها را بر اساس صدا به تنهای تشخیص دهد. هرچند که آموزش های بسیار زیاد سیستم ها و مدلهای آماری که امروزه به کار می رود تا حد زیادی کارایی این برنامه ها را افزایش داده است.

1-6-4- ایجاد سرو صدا

ایجاد سرو صدا یکی از محدودیت های این سیستم ها است. با توجه به لزوم تعامل صوتی انسان با این سیستم در هنگام استفاده این مشکل امری طبیعی است ولیکن برای کاهش مزاحمت و افزایش کارایی بهتر است که از این فناوری در محیط های خاص دربسته و مجزا استفاده شود. محدودیت دیگری که هنگام کار با این سیستم با آن مواجه می شویم خطر فاش شدن اطلاعات شخصی و محرمانه هنگام ورود اطلاعات است. یک راه ابتکاری و البته معقول وجود دارد و آن استفاده از ماسک های مخصوص مجهز به میکروفن حساس است. با استفاده از این ماسک ها می توان با پایین ترین فرکانس صوتی ممکن صحبت کرد به طوری که دیگران صدای ما را نشنوند ودر عین حال مطمئن باشیم که صدای ما از طریق میکروفن وارد شده است.

1-7- اصول تشخیص و سنتز گفتار

اصول تشخیص و سنتز گفتار در 5 مرحله انجام مي گيرد :

1- ورودي كاربر :

در اين مرحله، كاربر خواستة خود را بصورت بيان چند كلمه يا عبارت بيان مي كند. سيستم تشخيص گفتار، صداي كاربر رابصورت يك سيگنال صوتي آنالوگ ضبط مي كند.

2- رقمي سازي[57]

در اين مرحله، سيگنال صوتي آنالوگ به سيگنال ديجيتال تبديل مي شود.

3- تجزية اجزاي صدا[58]

نرم افزار تشخيص گفتار، سيگنال ديجيتال را به اجزاي اصلي تشكيل دهندة گفتار تجزيه مي كند. به عنوان مثال حروف صدا دار و بي صدا را تشخيص مي دهد.

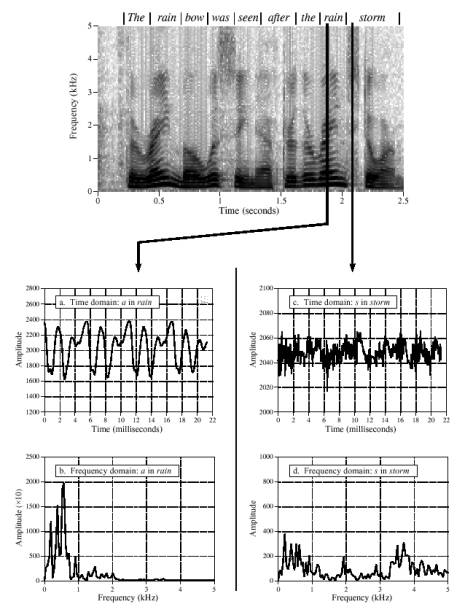

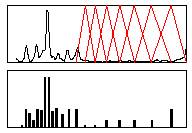

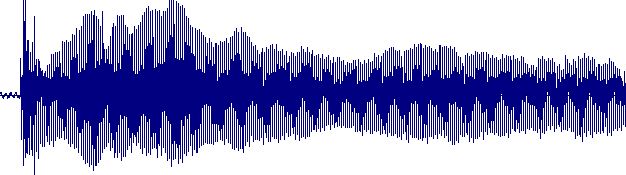

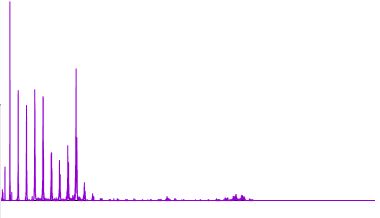

هر زبان مجموعه اي از صداهاي مختلف تشكيل شده است كه به هر كدام از اين اصوات يك واج گفته مي شود. تركيب واجها سيلاب يا هجاء را تشكيل مي دهد و از تركيب چند هجاء لغات به وجود مي آيند. هر واج را مي توان بصورتي يك الگوي مشخص در دستگاه اسپكتروگرام شناسايي كرد. تشخيص هر واج نيازمند به تمركز زيادي بر روي انرژي صوت دارد كه آن را فرمانت[59] مي نامند. فرمانت داراي خصوصيات افزايش و كاهش تدريجي[60] در تمامم فركانسها مي باشد كه يكي از ويژگي هاي برجستة صداي انسان است.

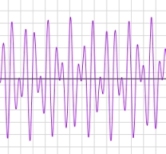

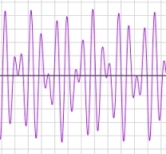

اسپكتروگرام در تحليل صدا به ما كمك مي كند. گفتار انسان از نوسانات صوتي حنجره ايجاد مي شود. اگرچه واجها در يك موج صوتي قابل شناسايي نيستند، اما موج صوتي را مي توان به فركانسهاي تشكيل دهندة آن تجزيه كرد و در يك اسپكتروگرام آن را نمايش داد. محور عمودي در اسپكتروگرام فركانسهاي بالاي 8000 هرتز را نمايش مي دهد و محور افقي بيانگر گذشت زمان مي باشد. رنگها نشانگر اهميت قله هاي صوتي صدا مي باشند. تغيير واجهاي يك لغت معني آن لغت را تغيير مي دهد. به عنوان مثال تفاوت دو كلمة Fat و Vat در يك واج مي باشدكه تغيير آن باعث تغيير معني لغت مي شود. در زبانهاي مختلف، لهجه هاي مختلف باعث تلفظ لغات بصورت مختلف مي شود. در زبان انگليسي 38 واج وجود دارد.

4- مدل كردن آماري

بعد از انجام مراحل فوق سيستم مشغول به تطبيق صداها با صداهاي تعريف شده در خودش مي شود. از

يك واژه نامه براي نگه داشتن طرز تلفظ لغات استفاده مي شود. ماشين تشخيص گفتار از اين فرهنگ، استفاده مي كند.

5- تطبيق دادن[61]

نرم افزار تشخيص گفتار تلفظهاي تشخيص داده شده را بر اساس لغات و عباراتي كه بصورت گرامري براي آن تعريف شده است تطبيق مي دهد. به عنوان مثال در يك نرم افزار صوتي مسافرتي، كاربر ممكن است كلمة ”درجه 2“ را براي رزرو كردن يك صندلي كه از نظر اقتصادي با صرفه تر است بكار ببرد، اما اگر كلمة ”درجه 2“ در نرم افزار مربوطه معادلي براي ”درجة اقتصادي“ نباشد، نرم افزار نمي تواند آن را بپذيرد.

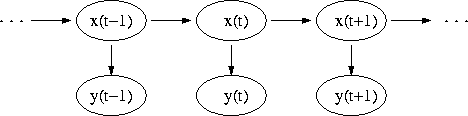

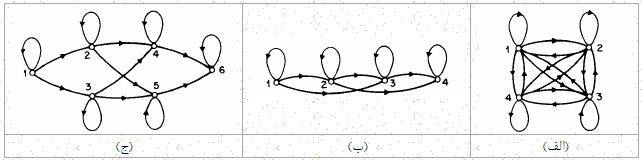

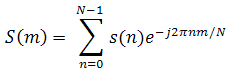

تكنولوژي مدل سازي زبانها براي افزايش درصد درستي بكار برده مي شود. بطوريكه صداهاي تشخيص داده شده بوسيلة ليستي از قانونها، صداهاي بعد از خودشان را پيش بيني مي كنند. در اين سيستم ليستي بر اساس لغات يا عبارات تطبيق داده شده با جملات گفته شده به همراه ضريب اطمينان[62] بازگردانده شود. يكي از روشهاي رايج پياده سازي، استفاده از مدل مخفي ماركوف HMM مي باشد. مدل مخفي ماركوف، بر اساس مدل رياضي پردازشش سيگنال ديجيتال مي باشد و يك سيستم پيچيده بر اساس مجموعه حالتهاي متناهي[63] را توصيف مي كند. اين حالتها شرايط رفتن از يك حالت به حالتت بعدي را بيان مي كنند. از مدل HMM براي پيش بيني زنجيره هاي پنهان استفاده مي شود. به عنوان مثال مي توان از اطلاعات صوتي كه بوسيلةة ميكروفون دريافت شده و به سيستم ارسال مي شو درا به صورت يك زنجير تلقي كرد.

1-8- صدا در کامپیوترهای شخصی:

مدت زیادی از ورودی صدا به دنیای کامپیوتر می گذرد و در این مدت تکنولوژی های مربوط به پردازش صوت پیشرفت های چشمگیری داشته اند. از زمان ورود صدای واقعی به دنیای کامپیوتر تکنولوژی های پردازش صوت تغییرات عمده ای را پشت سر گذاشته اند، این تغییرات شامل قوی تر شدن پردازنده های صوتی، بالا رفتن کیفیت ضبط و نمونه برداری صدا و … می باشد.

صدا در کامپیوتر در قالبهای مختلفی ایجاد و نگهداری می شود. به عنوان مثال در فرمت Mid اطلاعات صوتی بصورت نت ذخیره می شوند، یعنی اطلاعات مربوط به هر ساز، به همراه ساز، نت ها و سایر اطلاعات، جداگانه ذخیره می شوند ولی در فرمت Wav اطلاعات صوتی بصورت طول موج های صدا ذخیره می شود و صداها قابل تفکیک نیستند. تعدادی از مهمترین فرمتهای صوتی به این شرح است:

RA,Wma,Mp3,Wav,Mid ,…

اصول کارکرد دیجیتالی کردن صدا:

زمانی که کاربری در یک میکروفن صحبت می کند امواج صوتی میکروفن به امواج الکتریکی تبدیل می شوند. اما هنوز این امواج برای کامپیوترها قابل فهم نیستند. برای این کار سیگنالهای الکتریکی ساخته شده باید به روشی تبدیل به داده های دیجیتالی شوند. اینکار شامل سه مرحله است:

کوانتیزه کرن یا تقریب زدن[64] : برای آنکه هر سیگنال آنالوگی را بتوان به سیگنال دیجیتال تبدیل کرد قبل از هرکاری باید تعداد سطوح ممکن را مشخص کرد. همانطور که می دانیم در یک سیگنال دیجیتال سطوح ممکن 2 سطح است (صفر یا یک مثلا معادل با برق صفر ولت و 20 ولت). اما در سیگنال آنالوگگ یک سیگنال می تواند بین دو سطح مثلا صفر تا 20 ولت هر مقدار ممکنی داشته باشد، مثلا 15/7 ولت. برای اینکه بتوان چنین سیگنالی را به سیگنال دیجیتال تبدیل کرد در گام اول باید فرض کرد سیگنال موردنظر بین دو مقدار حداقل و حداکثر خود چه تعداد سطح دارد. به عنوان مثال برای کاربردهای تلفنی فرض می شود که یک سیگنال آنالوگ می تواند معادل یکی از 256 سطح بینابینی باشد و در غیر اینصورت سطح سیگنال در یک لحظه خاص به نزدیکترین مقدار سطح ولتاژ گرد می شود.

نمونه برداری[65]:

در مرحله بعد تعیین می شود که سیگنال آنالوگ باید در چه فاصله زمانی نمونه برداری شود. هر چه تعداد نقاط نمونه برداری بیشتر باشد دقت عملیات تبدیل و کیفیت سیگنال دیجیتال بدست آمده بالاتر خواهد بود. به مثال در سیستم های آنالوگ در هر ثانیه 4000 بار از سیگنال آنالوگ نمونه برداری می شود (تا بعد تعیین شود که در هر یک از این لحظه ها سطح سیگنال معادل کدام یک از آن 256 سطح ممکن است). در هر ثانیه چهار هزار بار نمونه برداری یعنی سرعت نمونه برداری معادل 4KHz است. این عدد در استانداردهای صوتی امروز بسیار پائین است. بد نیست بدانید که سرعت نمونه برداری برای یک سیگنال صوتی مربوط به موسیقی در حد کیفیت FM معادل KHz 22 و برای سیستم های صوتی با کیفیت CD معادل با KHz 44 است.

کدگذاری[66] :

در آخرین مرحله باید اندازه یا سطح سیگنال را در هریک از لحظات نمونه برداری کرده و آنرا به زبان دیجیتال تبدیل کنیم.

به منظور فهم بیشتر مراحل دیجیتالی کردن صدا، به مثال زیر توجه کنیم:

با توجه به اینکه فرکانس موج مکالمه انسان به طور کلی از صفر تا چهار کیلوهرتز در نظر گرفته می شود، مراحل به این گونه انجام می شوند:

- کوانتیزه کردن: تنها 8 سطح اندازه گیری در نظر می گیریم و مقدار آستانه را مقدار میانی هر سطح ولتاژ داریم.

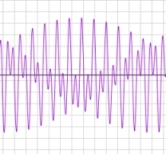

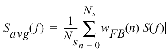

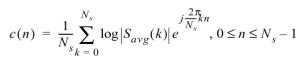

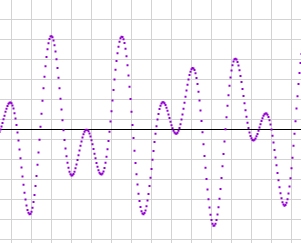

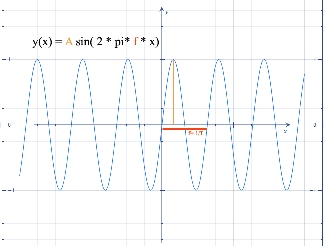

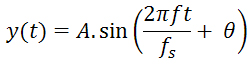

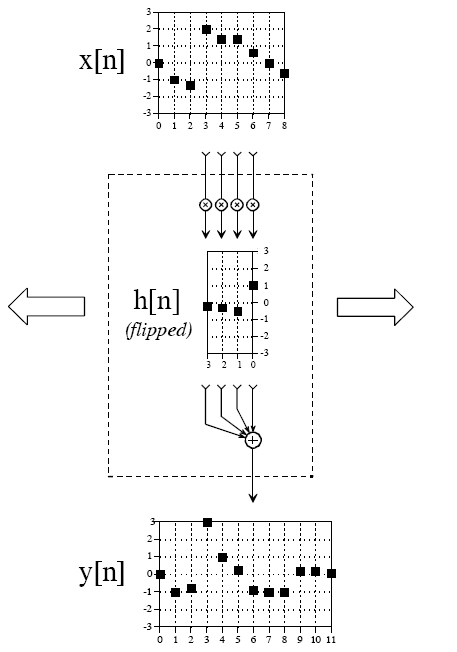

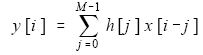

- نمونه برداری: عمل نمونه برداری بوسیله ضرب موج اصلی در یک تابع مخصوص انجام می شود:

شکل 1-15

شکل موج X(t) :

X(t)=sin(t)

شکل موج نمونه برداری Y(t):

فاصله نمونه برداری اینطور تعیین می شود:

=4KHz= F ماکسیمم فرکانس موج ورودی (موج مکالمه)

2*F=8KHz

میکرو ثانیه =T=125 دوره تناوب

حاصلضرب دو تابع:

- کدگذاری: در این مرحله با توجه به اینکه 8 سطح ولتاژ فرض کرده ایم عمل کدگذاری را انجام می دهیم.

شکل 1-16

اگر مقدار آستانه در نظر گرفته نشود برای بعضی از نمونه ها نمی توان کدی بدست آورد چون روی سطح مشخصی قرار ندارند. بنابراین مقدار آستانه را بین دو سطح در نظر گرفته، اگر مقدار نمونه روی سطح یا بزرگتر بود به مقدار بالایی و اگر کوچکتر بود به مقدار پائینی گرد می کنیم و در نهایت برای هر نمونه کد مربوط به آنرا ذخیره می کنیم به این صورت است که صدا در کامپیوتر بصورت صفر و یک ذخیره می شود.

فصل دوم – پردازش صوت

2-1- دستگاه شنوایی انسان

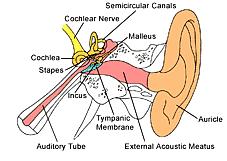

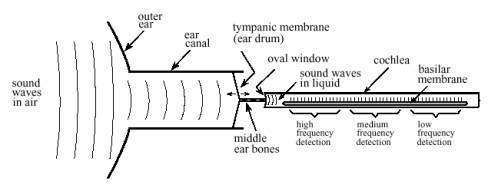

شکل2-1

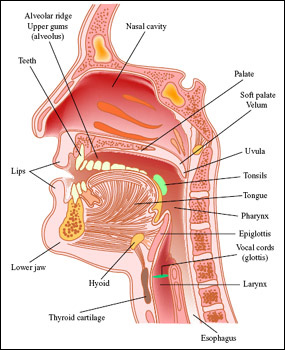

پردازش صوت محدودههای گوناگونی را در بر میگیرد که همه به منظور ارائهی صدا به شنوندگان انسانی ابداع شدهاند. سه محدودهی تکثیر موسیقی با کیفیتی به خوبی اصل همانند آنچه در سیدیهای صوتی وجود دارد، ارتباط صوتی از راه دور که نام دیگر شبکهی تلفنی است و ترکیب صحبت که در آن کامپیوترها الگوهای صوتی انسان را تولید کرده یا تشخیص میدهند از دیگر قلمروهای دانش پردازش صوت مهمترند. با وجود این که اهداف و مسائل این کاربردها متفاوتند همگی در یک نقطهی مشترک به هم میرسند و آن گوش انسان است.

گوش انسان یک عضو به گونهای فزاینده پیچیده است. قضیه وقتی پیچیدهتر میشود که اطلاعات ارسالی از دو گوش در یک شبکهی پیچیدهی گیج کننده که همانا مغز انسان باشد با هم ترکیب میشوند. به یاد داشته باشیم که بیان فوق یک گذر کلی بر قضیه است و تعداد زیادی از پدیدهها و آثار دقیق مرتبط با گوش انسان هنوز به درستی درک نشدهاند.

شکل 2-1 قسمت اعظم ساختارها و پردازشهایی را که گوش انسان را در بر دارند به تصویر میکشد. گوش خارجی از دو بخش تشکیل شده است: نرمی پوست قابل مشاهده و غضروف متصل به کنار سر و کانال گوش که لولهایست به قطر تقریبی ۰.۵ سانتیمتر و تا حدود ۳ سانتیمتر در داخل سر فرو میرود. این ساختارها صداهای محیط را به بخشهای حساس گوش میانی و گوش داخلی که در درون استخوانهای جمجمه محافظت میشود راهبری میکنند. در انتهای کانال گوش یک ورقهی نازک از نسوج که پردهی صماخ یا طبل گوش نامیده میشود کشیده شده است. امواج صدا با برخورد به پردهی صماخ باعث لرزش آن میشوند. گوش میانی مجموعهای از استخوانهای کوچک است که لرزش مزبور را به حلزون گوش(گوش داخلی) انتقال میدهند و در آنجا این لرزشها تبدیل به ضربههای عصبی میگردند. حلزون گوش یک لولهی پر از مایع است که به زحمت قطر آن به ۲ میلیمتر و طول آن به ۳ سانتیمتر میرسد. اگر چه حلزون گوش در شکل شماره ۱ به صورت یک لولهی مستقیم نشان داده شده اما در واقع به دور خودش همانند صدف حلزون پیچ خورده است و وجه تسمیهی آن که ریشه در کلمهای یونانی به معنای حلزون دارد نیز این واقعیت است.

وقتی یک موج صوتی سعی دارد از هوا وارد مایع شود تنها کسر کوچکی از آن از بین دو محیط عبور میکند و باقیماندهی انرژی آن بازتابیده میشود. دلیل این امر مقاومت مکانیکی پایین هوا (ناشی از پایین بودن میزان فشار صوتی و سرعت بالای ذرات هوا که به نوبهی خود از چگالی پایین و تراکمپذیری بالای آنها نشأت میگیرد) در برابر مقاومت مکانیکی بالای مایع است. به عبارت سادهتر دلیل این امر مشابه دلیل این موضوع است که برای ایجاد موج با دست در درون آب به تلاش بیشتری به نسبت انجام این کار در هوا نیازمندیم. تفاوت موجود باعث بازتابش قسمت اعظم صوت در مرز هوا/مایع میگردد.

گوش میانی یک شبکهی تطبیق مقاومت است که کسر انرژی صوتی وارد شده به مایع گوش داخلی را زیاد میکند. برای نمونه ماهی پردهی صماخ یا گوش میانی ندارد چرا که نیازی به شنیدن در هوا ندارد. تغییر شدت، بیشتر ناشی از تفاوت مساحت پردهی صماخ (که صدا را از هوا دریافت میکند) و دریچه بیضوی (که مطابق شکل ۱صدا را به داخل مایع انتقال میدهد) میباشد. مساحت پردهی صماخ حدوداً ۶۰ میلیمتر مربع است حال آن که دریچهی بیضوی حدوداً ۴ میلیمتر مربع مساحت دارد. از آنجا که فشار برابر است با نسبت نیرو به مساحت، این تفاوت مساحت فشار موج صدا را حدوداً ۱۵ برابر افزایش میدهد.

در داخل حلزون گوش پردهی اصلی قرار دارد که ساختاری را برای ۱۲۰۰۰ سلول حسی که شکلدهندهی عصب حلزونی است ایجاد میکند. پردهی اصلی در نزدیکی دریچهی بیضوی بسیار سفت است و در انتهای دیگر انعطافپذیرتر است که این امر به این عضو کمک میکند تا به عنوان تحلیلگر طیف فرکانسی عمل کند. وقتی پردهی اصلی در معرض یک سیگنال با فرکانس بالا قرار میگیرد در قسمت سفتتر طنین میاندازد که سبب تحریک سلولهای عصبی نزدیک به دریچهی بیضوی میگردد. به همین ترتیب فرکانسهای پایین موجب تحریک انتهای دورتر پردهی اصلی میشوند. این امر موجب پاسخگویی رشتههای خاص عصب حلزونی در برابر فرکانسهای خاص میگردد. این سازوکار اصل مکان نامیده میشود و در سراسر مسیر به سمت مغز حفظ میشود.

طرح کدگذاری اطلاعات دیگری نیز در شنوایی انسان به کار میرود که اصل رگبار نامیده میشود. سلولهای عصبی اطلاعات را با تولید پالسهای الکتریکی کوچکی که پتانسیل کنش نامیده میشوند انتقال میدهد. یک سلول عصبی واقع بر پردهی پایینی میتواند اطلاعات صوتی را با تولید یک پتانسیل کنش در پاسخ هر سیکل لرزش کدگذاری کند. برای نمونه یک موج صدای ۲۰۰ هرتزی میتواند توسط یک نورون ایجاد کنندهی ۲۰۰ پتانسیل کنش در ثانیه نشان داده شود. در هر صورت این روش تنها در فرکانسهای زیر حدوداً ۵۰۰ هرتز – بالاترین سرعت ممکن تولید پتانسیل کنش در نورونها – به کار میآید. گوش انسان برای غلبه بر این مشکل به نورونها اجازه میدهد که برای انجام این کار دستهجمعی عمل کنند. برای نمونه یک صدای ۳۰۰۰ هرتزی میتواند توسط ده سلول عصبی که هر کدام ۳۰۰ ضربه در ثانیه علامت میدهند نشان داده شود. این پدیده بازهی کارایی اصل رگبار را تا ۴ کیلوهرتز گسترش میدهد که بالاتر از بازهی عملیاتی اصل مکان میباشد.

شکل2-2- توضیحات مربوط به شکل: نمودار کارکردی گوش انسان. گوش خارجی امواج صوتی را از محیط میگیرد و آنها را به سوی پردهی صماخ (طبل گوش) که ورقهی نازکی از بافت است و هماهنگ با شکل موج هوا میلرزد راهبری میکند. استخوانهای گوش میانی (استخوانهای چکشی، سندانی و رکابی) این لرزشها را به دریچهی بیضوی که پردهای منعطف واقع در حلزون گوش پر از مایع است انتقال میدهند. در داخل حلزون گوش پردهی اصلی قرار دارد که ایجاد کنندهی ساختاری برای ۱۲۰۰۰ سلول عصبی شکلدهندهی عصب حلزون گوش است. بسته به سفتی متغیر پردهی پایینی، هر سلول فقط به بازهی کوچکی از فرکانسهای صدا پاسخ میدهد که این پدیده گوش را تبدیل به یک تحلیلگر طیف فرکانسی مینماید.

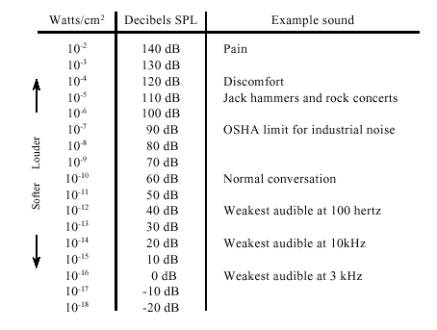

شکل شماره 2-۲ رابطهی بین شدت صدا و بلندی مشاهده شده را نشان میدهد. غالباً شدت صدا را با یک اندازهی لگاریتمی که دسیبل اس.پی.ال (سطح توان صدا) نامیده میشود نشان میدهند. در این معیار۰ دسیبل اس.پی.ال موج صدایی با قدرت ده به توان منفی شانزده وات بر سانتیمتر مربع است که حدوداً ضعیفترین صدای قابل تشخیص توسط گوش انسان است. صحبت معمولی حدوداً ۶۰ دسیبل اس.پی.ال است و صدایی با شدت ۱۴۰ دسیبل اس.پی.ای برای گوش دردناک و زیانآور است

.

شکل شماره 2-3 – واحدهای شدت صدا. شدت صدا به صورت توان بر واحد مساحت تعریف میشود (مثلاُ وات بر سانتیمتر مربع) یا به صورت معمولتر با استفاده از یک اندازهی لگاریتمی که دسیبل اس.پی.ال خوانده میشود. همچنان که این جدول نشان میدهد قوهی شنوایی انسان بیشتر به صداهای بین ۱کیلوهرتز تا ۴ کیلوهرتز حساس است.

- پیش بینی سری زمانی به کمک شبکه عصبی در متلب

- تشخیص فونم ها(لب خوانی) با SVM در متلب

- راهکار ارائه پیشنهاد تطبیقی بر اساس یادگیری-Q در حراجهای ترکیبی

- ماشین های القایی متقارن در متلب

- سفارش پروژه های دینامیک سیالات محاسباتی با متلب

اختلاف بلندترین و ضعیفترین صداهایی که انسان میتواند بشنود ۱۲۰ دسیبل است که از لحاظ دامنه معادل بازهای حدود یک میلیون است. شنونده تغییر بلندی صدا را وقتی صدا حدود ۱ دسیبل (۱۲% در دامنه) تغییر کند تشخیص میدهد به عبارت دیگر تنها ۱۲۰ سطح بلندی صدا از ملایمترین نجوا تا بلندترین تندر قابل تشخیص است. حساسیت گوش آنقدر جالب توجه است که هنگام شنیدن به ضعیفترین صداها پردهی صماخ به اندازهای کمتر از قطر یک ملکول به لرزش درمیآید!

احساس بلندی صدا با توان صدا رابطهی توانی با نمای ۱/۳ دارد. به عنوان نمونه اگر شما توان صدا را ده برابر کنید شنوندگان آن صدا دو برابر شدن بلندی صدا را احساس و گزارش میکنند.

این مسأله یک مشکل بزرگ برای حذف صداهای محیطی ناخواسته به وجود میآورد. برای نمونه فرض کنید که شما ۹۹% دیوار را با عایق صوتی پوشاندهاید و تنها ۱% که مربوط به درها، گوشهها، منافذ و… هستند باقی ماندهاند. با وجود آن که توان صدا تا اندازهی ۱% مقدار اولیهی آن کاسته شده بلندی صدا تنها به اندازهی ۲۰% کاهش پیدا کردهاست.

بازهی شنیداری انسان بین ۲۰ هرتز تا ۲۰ کیلوهرتز در نظر گرفته میشود، حال آن که بیشتر صداهای قابل حس در بازهی ۱ کیلوهرتز تا ۴ کیلوهرتز قرار دارند. برای نمونه شنوندگان میتوانند صدایی به میزان صفر دسیبل را در فرکانس ۳ کیلوهرتز بشنوند حال آن که برای شنیدن یک صدای ۱۰۰ هرتزی حداقل مقدار آن باید ۴۰ دسیبل باشد. شنوندگان میتوانند بگویند که دو صدا متفاوتند اگر فرکانس آنها بیش از حدود %۰.۳ در ۳ کیلوهرتز متفاوت باشد. به عنوان نمونه کلیدهای کنار هم در پیانو به اندازهی حدود ۶% تفاوت فرکانس دارند.

مهمترین مزیت داشتن دو گوش تشخیص جهت صداست. شنوندگان انسانی میتوانند تفاوت بین دو منبع صدا را که فاصلهای به کمی ۳ درجه دارند (حدوداً برابر با عرض یک انسان در فاصلهی ده متری) تشخیص دهند. این اطلاعات جهتی به دو روش جداگانه به دست میآیند. اولاً فرکانسهای حدوداً بالای ۱ کیلوهرتز به شدت زیر سایهی سر قرار میگیرند. به بیان دیگر گوشی که به منبع نزدیکتر است سیگنال قوی تری را به نسبت گوشی که در جهت مخالف دارد دریافت میکند. روش دیگر تشخیص جهت آن است که گوش دورتر به خاطر فاصلهی بیشترش از منبع صدا را کمی دیرتر از گوش نزدیکتر دریافت میکند. به واسطهی اندازهی معمول سر (حدوداً ۲۲ سانتیمتر) و سرعت صوت (حدود ۳۴۰ متر در ثانیه) تفاوتگذاری زاویهای سه درجه دقت زمانی حدود ۳۰ میکروثانیه نیاز دارد. چون این فاصلهی زمانی نیازمند اصل رگبار است این روش جهتیابی برای صداهای دارای فرکانس کمتر از حدود ۱ کیلوهرتز به کار میرود.

در حالی که قوهی شنوایی انسان میتواند جهت صدا را تشخیص دهد در نشخیص فاصلهی منبع صدا مشکل دارد. این امر بدان علت است که چیزهای کمی در موج صدا وجود دارد که اطلاعات این گونه را در اختیار بگذارد. شنوایی انسان به صورت ضعیفی در مییابد که منابع صداهای با فرکانس بالا نزدیکند و صداهای با فرکانس پایین از فاصلهی دورتری پخش میشوند. این به آن دلیل است که صداها در فاصلههای دور از میزان فرکانسشان کاسته میشود. پژواک روش ضعیف دیگری برای تشخیص فاصله است و با استفاده از آن مثلاً میتوان ابعاد یک اتاق را حدس زد. برای نمونه صداهای موجود در یک تالار بزرگ پژواکهایی با وقفهی ۱۰۰ میلی ثانیه دارند، حال آن که برای یک دفتر کار کوچک این مقدار ۱۰ میلی ثانیه است. بعضی از موجودات با استفاده از دستگاه طبیعی تشخیص فاصلهی صوتی مسألهی فاصلهیابی را حل کردهاند. مثلاً خفاشها و دلفینها صداهایی مثل تیک و جیغ تولید میکنند که از سوی اشیاء نزدیک بازتابیده میشوند. با اندازهگیری میزان وقفهی بازتاب این صداها این جانوران میتوانند با دقت ۱سانتیمتر اشیاء را مکانیابی کنند. تجربیات نشان دادهاند که بعضی انسانها به خصوص نابینایان تا حد کمی از روش مکانیابی با استفاده از پژواک استفاده میکنند.

2-2- ویژگیهای امواج صوتی

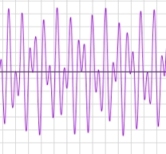

شکل2-4

غالباً برای درک یک صوت پیوسته مثل نت یک ابزار موسیقیایی سه بخش مجزا را باید تشخیص داد: بلندی صدا، زیری یا بمی صدا (پیچ) و طنین صدا. بلندی همانگونه که قبلاً توضیح داده شد معیاری برای شدت موج صوتی است. پیچ، فرکانس جزء اصلی صدا – فرکانسی تکرار موج صوتی توسط خودش – میباشد.

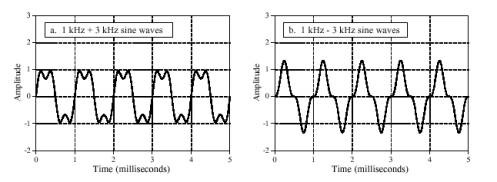

طنین صدا از دو جزء قبلی پیچیدهتر است و با تعیین محتوای همساز صدا تعیین میگردد. شکل شماره ۳ دو موج را که هر دو از جمع یک موج سینوسی یک کیلوهرتزی با دامنهی یک و یک موج سینوسی سه کیلوهرتزی با دامنهی یک دوم به وجود آمدهاند نشان میدهد. تفاوت آنها در آن است که در شکل b جزء با فرکانس بالاتر ابتدا معکوس شده و سپس با موج دوم جمع شده است. علیرغم موجهای در دامنهی زمان بسیار متفاوت این دو صوت یکسان به نظر میرسند. این به خاطر آن است که شنوایی انسان بر اساس دامنهی فرکانسهاست و نسبت به فاز آنها بسیار غیر حساس است. شکل موج صوتی در دامنهی زمان فقط به صورت غیر مستقیم با شنوایی رابطه دارد و معمولاُ در سیستمهای صوتی در نظر گرفته نمیشود.

عدم حساسیت گوش به فاز صدا با توجه به روش پخش شدن آن در محیط قابل درک است. فرض کنید که شما در یک اتاق به صحبتهای فردی گوش میدهید. بیشتر صداهایی که گوش شما دریافت میکند حاصل بازتاب صدای اصلی از دیوارها، سقف و کف اتاق است. از آنجا که انتشار صدا بستگی به فرکانس آن دارد و میرایی، بازتاب و مقاومت در برابر صدا بر روی آن تأثیرگذار است فرکانسهای متفاوتی از مسیرهای متفاوت به گوش میرسد. این به این معنی است که وقتی شما جای خود را در اتاق عوض میکنید فاز هر یک از فرکانسها تغییر میکند. چون گوش این تغییر فازها را نادیده میانگارد با وجود تغییر مکان شما تغییری در صدای شخص صحبت کننده احساس نمیکنید. از دیدگاه فیزیکی فاز یک سیگنال صدا در هنگام پخش در یک محیط پیچیده به صورت تصادفی تغییر میکند. از طرف دیگر گوش به فاز صدا غیر حساس است زیرا این جزء دارای اطلاعات قابل استفادهی بسیار کمی میباشد.

شکل شماره 2-5 – تشخیص فاز توسط گوش انسان. گوش انسان نسبت به فاز نسبی سینوسیهای مرکب بسیار غیر حساس است. برای نمونه این دو موج یکسان به نظر خواهند رسید، زیر دامنهی اجزاء آنها یکسان است اگر چه فاز نسبی آنها متفاوت است.

در حالت کلی نمیتوان گفت که گوش نسبت به فاز کاملاً ناشنواست. چرا که تغییر فاز میتواند باعث تغییر آرایش زمانی یک سیگنال صوتی شود. اما چنین امری یک پدیدهی نادر است که در محیطهای شنیداری طبیعی اتفاق نمیافتد.

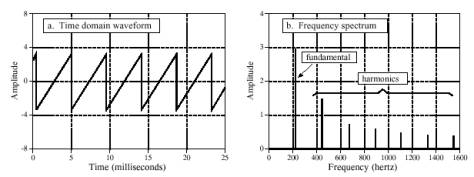

فرض کنید از یک نوازندهی ویولون خواستهایم نتی را بنوازد. وقتی که موج صوتی ایجاد شده بر روی اسیلوسکوپ نشان داده شود یک موج دندانهارهای مانند شکل شماره ۴ (a) مشاهده میشود. شکل شماره ۴ (b) نشان میدهد که این صوت چگونه توسط گوش دریافت میشود. گوش یک فرکانس اساسی (در مثال شکل ۲۲۰ هرتز) را و همسازهایی را در ۴۴۰، ۶۶۰، ۸۸۰ و… هرتز دریافت میکند. اگر این نت بر روی ابزار دیگری نواخته شود گوش هنوز هم همان ۲۲۰ هرتز (همان فرکانس اساسی) را دریافت میکند. و از این لحاظ دو صوت مشابهند که گفته میشود این دو صوت پیچ یکسانی دارند ولی چون دامنهی همسازها متفاوت است دو صوت یکسان نیستند و گفته میشود که طنین دو صوت متفاوت است.

شکل شماره 2-6 – موج صوتی ویولن. ویولن موج دندانهارهای ایجاد میکند(شکل a)، صدای دریافت شده شامل فرکانس اساسی و همسازهای آن است (شکل b)

اغلب گفته میشود که طنین صدا از روی شکل موج صوتی تعیین میگردد. این مسأله درست است ولی کمی گمراه کننده است. احساس طنین صدا از روی میزان هارمونیکهای تشخیص داده شده توسط گوش تعیین میگردد. در حالی که هارمونیکها از روی شکل موج صوتی تعیین میگردد عدم حساسیت گوش به فاز رابطه را بسیار یک طرفه میکند. به همین دلیل هر موج صوتی فقط یک طنین دارد حال آن که یک زنگ خاص متعلق به تعداد بینهایتی از موجهای صوتی است.

- الگوریتم جستجوی کلاغ ها به همراه کد متلب

- مقالات شبیه سازی شده با متلب کد جیg -بخش دوم

- سفارش شبیه سازی مباحث درس دینامیک سیستم های قدرت

- توابع سینوسی با متلب و با دستور stem

- قسمت سوم بانک مقالات شبیه سازی شده برق قدرت

گوش بیشتر برای شنیدن هارمونیکهای اساسی تنظیم شده است. اگر یک شنونده به صدایی که حاصل ترکیب دو موج صوتی سینوسی ۱ کیلوهرتز و ۳ کیلوهرتز است گوش دهد آن را مطلوب و طبیعی توصیف خواهد کرد حال آن که اگر از موجهای ۱ کیلوهرتزی و ۳.۱ کیلوهرتزی استفاده شود برای شنونده شکایت برانگیز خواهد بود. این مسأله اساسی برای اندازهها و اختلافهای استاندارد ابزارهای موسیقیایی فراهم میآورد.

2-3- روشهای دیجیتالی ذخیرهی صدا

در طراحی یک سیستم صوتی دیجیتال دو پرسش وجود دارند که باید پاسخ داده شوند: ۱- چقدر لازم است صوت خوب به نظر برسد؟ ۲- چه نرخ دادهای قابل تحمل است؟ جواب به این پرسشها غالباً به یکی از این سه انتخاب منجر میشود: اول موسیقی با وفاداری بالا که در آن کیفیت صدا مهمترین چیز است و تقریباً هر نرخ دادهای قابل قبول است. دوم ارتباط تلفنی که نیازمند طبیعی به نظر رسیدن صحبت و یک نرخ دادهی پایین برای کاهش هزینهی سیستم است. سوم صحبت فشرده شده که در آن کاهش نرخ داده بسیار مهم است و مقداری غیر طبیعی به نظر رسیدن کیفیت صدا قابل تحمل است. این مورد در بر دارندهی ارتباطات نظامی، تلفنهای سلولی و صحبت ذخیره شده به صورت دیجیتال برای پست الکترونیکی صوتی یا کاربردهای چند رسانهای است.

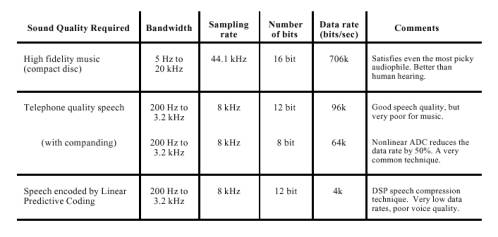

شکل شماره 2-5 بده بستانهای موجود در انتخاب هر یک از این سه روش را نشان میدهد.

در حالی که موسیقی نیازمند پهنای باند ۲۰ کیلوهرتز است صحبتی که طبیعی به نظر برسد فقط به پهنای باندی در حدود ۳.۲ کیلوهرتز نیازمند است. در این حال هر چند پهنای باند به اندازهی ۱۶% مقدار اولیه محدود میشود ولی فقط ۲۰% اطلاعات اولیه از دست میرود.

سیستمهای ارتباط راهدور اغلب از نرخ نمونهبرداری در حدود ۸ کیلوهرتز استفاده میکنند که اجازهی انتقال صحبت را با کیفیتی در حد طبیعی میدهد ولی اگر از آن برای انتقال موسیقی استفاده شود تا میزان بالایی از کیفیت آن از دست میرود. شما احتمالاً با تفاوت این دو میزان آشنایی دارید: ایستگاههای رادیویی اف.ام با پهنای باندی در حدود ۲۰ کیلوهرتز اقدام به پخش میکنند حال آن که ایستگاههای ای.ام محدود به ۳.۲ کیلوهرتز هستند. صحبت و صداهای معمول روی ایستگاههای نوع دوم طبیعی به نظر میرسد حال آن که موسیقی این گونه نیست.

شکل شماره 2-7- نرخ دادهی صوتی در برابر کیفیت صدا. کیفیت صدای یک سیگنال صوتی دیجیتال به نرخ دادهی آن که برابر با حاصلضرب نرخ نمونهبرداری آن در تعداد بیتهای آن در هر نمونه بستگی دارد که به سه بخش تقسیم میشود: موسیقی باوفاداری بالا (۷۰۶کیلوبیت بر ثانیه)، صحبت با کیفیت تلفن ۶۴کیلوبیت بر ثانیه وصحبت فشرده شده (۴ کیلوبیت بر ثانیه)

سیستمهایی که فقط با صدا (و نه موسیقی) سر و کار دارند میتوانند مقدار دقت را از ۱۶ بیت به ۱۲ بیت بدون از دست رفتن دقتی قابل توجه کاهش دهند. این میزان میتواند با انتخاب اندازهی نامتساوی برای گام مقدارگزینی میتواند به ۸ بیت در هر نمونه نیز کاهش یابد. یک نرخ نمونهبرداری ۸ کیلوهرتز با دقت ای.دی.سی ۸ بیت در هر نمونه به نرخ دادهی ۶۴کیلوبیت بر ثانیه میانجامد. این یک حد نهایی برای طبیعی به نظر رسیدن صحبت است. دقت کنید که صحبت نیازمند نرخ دادهای معادل ۱۰% نرخ دادهی موسیقی با وفاداری بالاست.

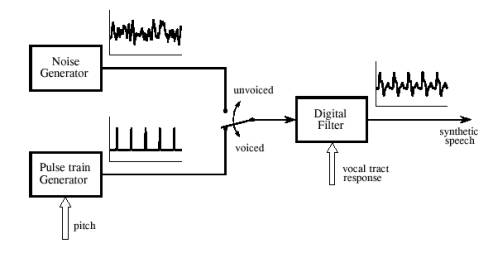

نرخ دادهی ۶۴ کیلو بیت بر ثانیه نمایانگر کاربرد نهایی نظریهی نمونهبرداری و مقدارگزینی برای سیگنالهای صوتی است. روشهای کاهش نرخ داده به اندازهای بیشتر از این مبتنی بر فشردهسازی جریان داده با حذف تکرارهای ذاتی سیگنال صحبت است. یکی از کاراترین روشهای موجود ال.پی.سی است که انواع و زیرگروههای متعدد دارد. بر اساس کیفیت سیگنال صحبت مورد نیاز این روش میتواند نرخ داده را تا اندازهای بین ۲ تا ۶ کیلو بیت بر ثانیه کاهش دهد.

2-4- برنامهنویسی و پیادهسازی پردازش صوت

2-4-1- ساختار مورد نیاز برای نگهداری ویژگیهای صدا

همانطور که اشاره شد برای ذخیره یا بازخوانی یک نمونه صدا به صورت دیجیتال نیازمند آنیم که برخی ویژگیهای خاص صدای دیجیتالی از قبیل نرخ نمونهبرداری، تعداد بیت هر نمونه و یککاناله یا دوکاناله بودن صدا را مشخص کنیم.

برای این منظور در محیط برنامهنویسی مورد نظر ما (ویندوز) از ساختاری به نام WAVEFORMATEX استفاده میگردد که به صورت زیر تعریف میگردد:

typedef struct {

WORD wFormatTag;

WORD nChannels;

DWORD nSamplesPerSec;

DWORD nAvgBytesPerSec;

WORD nBlockAlign;

WORD wBitsPerSample;

WORD cbSize;

} WAVEFORMATEXX;

در این ساختار فیلد wFormatTag فرمت فایل را که نشان دهندهی نوع الگوریتمهای به کار گرفته شده برای فشردهسازی صدا و… است را مشخص میکند. برای استفادهی مورد نظر ما فرمت خاصی که با ثابت WAVE_FORMAT_PCM مشخص میگردد و فرمت پی.سی.ام نامیده میشود مناسب است. علاوه بر آن فیلد cbSize برای فرمتهای غیر پی.سی.ام استفاده میشود و ما همواره مقدار آن را صفر در نظر خواهیم گرفت.

از آنجا که پردازش این ساختار در برنامهنویسی صدا برای پروژهی مورد نظر بارها صورت میگیرد و از آنجا که یک شیوهی طراحی شیءگرا (شیوهی ام.اف.سی) برای پیادهسازی پروژه در نظر گرفته شده بود و از آنجا که پردازش این ساختار نیاز به برخی محاسبات تکراری (تعیین nBlockAlign و nAvgBytesPerSec) دارد و به چند دلیل دیگر تصمیم گرفته شد که این ساختار و پردازش آن به صورت یک کلاس با نام HSound پیاده سازی گردد که ضمن خودکار نمودن پردازش این ساختار کلاسهایی که به اعمال پخش و ضبط را بر عهده دارند از این کلاس ارثبری نموده برنامه نویسی را آسانتر و کد به دست آمده را خواناتر نمایند.

تعریف این کلاس به صورت زیر است:

class HSound

{

public:

//constructor and destructor:

HSound();

virtual ~HSound();

//setting wave data:

void SetBitsPerSample(int bps);

void SetSamplesPerSecond(int sps);

void SetNumberOfChannels(int nchan);

//retrieving wave data:

WAVEFORMATEX* GetFormat();

int GetSamplesPerSecond();

int GetBitsPerSample();

int GetNumberOfChannels();

protected:

WAVEFORMATEX m_wfData;

private:

void Update();

};

قبل از هر چیز باید به این نکته اشاره شود که این کلاس برای پردازش فرمت پی.سی.ام در نظر گرفته شده، لذا ضمن تعریف مقادیر پیشفرض لازم برای این فرمت و استفاده از روشهای خاص این فرمت برای محاسبهی فیلدهای مختلف امکان تغییر فرمت و استفاده از سایر فرمتها را به برنامهنویس نمیدهد و به منظور پردازش سایر فرمتها ساختار کلاس میبایست تغییر کند.

فیلد wBitsPerSample تعداد بیتِ هر نمونه را مشخص میکند که برای فرمت پی.سی.ام فقط میتواند یکی از دو مقدار ۸ و ۱۶ را داشته باشد و برای سایر فرمتها مقادیر ممکن بستگی به مشخصات منتشر شده توسط شرکتهای به وجود آورنده و پشتیبانیکنندهی آنها دارد.

متدی که در پی میآیند آن را مقدارگذاری میکند (در مورد متد Update و علت فراخوانی آن در ادامه توضیح داده خواهد شد :

void HSound::SetBitsPerSample(int bps)

{

m_wfData.wBitsPerSample = bps;

Update();

}

و متد زیر مقدار انتخاب شده را برمیگرداند:

int HSound::GetBitsPerSample()

{

return m_wfData.wBitsPerSample;

}

فیلد nSamplesPerSec تعداد نمونهها در هر ثانیه (نرخ نمونهبرداری) را مشخص میکند. برای فرمت پی.سی.ام مقادیر معمول ۸کیلوهرتز (۸۰۰۰)، ۱۱.۰۲۵کیلوهرتز (۱۱۰۲۵)، ۲۲.۰۵کیلوهرتز (۲۲۰۵۰) و ۴۴.۱کیلوهرتز (۴۴۱۰۰) میباشد و برای سایر فرمتها مقادیر ممکن بستگی به مشخصات منتشر شده توسط شرکتهای به وجود آورنده و پشتیبانیکنندهی آنها دارد.

متد مقدارگذاری این فیلد:

void HSound::SetSamplesPerSecond(int sps)

{

m_wfData.nSamplesPerSec = sps;

Update();

}

و متد دریافت مقدار آن:

int HSound::GetSamplesPerSecond()

{

return m_wfData.nSamplesPerSec;

}

فیلد nChannels تعداد کانالهای موج صوتی را مشخص میکنند. صداهای تک کانال (مقدار فیلد برابر با ۱) مونو و صداهای دوکاناله (مقدار فیلد برابر با ۲) استریو خواهند بود.

متد مقدارگذاری این فیلد:

void HSound::SetNumberOfChannels(int nchan)

{

m_wfData.nChannels = nchan;

Update();

}

و متد دریافت مقدار آن:

int HSound::GetNumberOfChannels()

{

return m_wfData.nChannels;

}

هر چند تعداد کانالهای صدا در این کلاس قابل تغییراست اما در کلاسهای مشتق شده همواره الگوریتمها برای موج صوتی تککاناله نوشته شدهاند و استفاده از آنها برای پردازش موج صوتی دو کاناله نیازمند دستکاری کد این کلاسهاست که به لحاظ استفادهای که ما از این کلاسها نمودهایم یک کار اضافی و غیرضروری به نظر میرسد.

فیلد nBlockAlign کمینهی تعداد واحد داده را برای فرمت انتخاب شده تعیید میکند که اگر فرمت انتخاب شده پی.سی.ام باشد برابر با حاصل ضرب تعداد کانالها (nChannels) در تعداد بیتِ هر نمونه (nBitsPerSample) تقسیم بر تعداد بیتهای موجود در هر بایت (۸) خواهد بود و برای سایر فرمتها بستگی به مشخصات منتشر شده توسط شرکتهای به وجود آورنده و پشتیبانیکنندهی آنها دارد. فیلد nAvgBytesPerSec نیز تعداد متوسط بایتهای موجود در هر ثانیهی صدا را مشخص میکند و برای فرمت پی.سی.ام برابر با تعداد نمونههای موجود در هر ثانیه (nSamplesPerSec) در کمینهی تعداد واحد داده (nBlockAlign) خواهد بود و برای سایر فرمتها بستگی به مشخصات منتشر شده توسط شرکتهای به وجود آورنده و پشتیبانیکنندهی آنها دارد.

متد Update که در کد مقدارگذاری سایر فیلدها محاسبات توضیح داده شدهی بالا را انجام میدهد:

void HSound::Update()

{

m_wfData.nBlockAlign = m_wfData.nChannels*(m_wfData.wBitsPerSample/8);

m_wfData.nAvgBytesPerSec = m_wfData.nSamplesPerSec*m_wfData.nBlockAlign;

}

در صورتی که نیاز باشد با ساختار اصلی WAVEFORMATEX کار شود متد زیر مقدار عضوی از کلاس را که از این نوع است باز میگرداند:

WAVEFORMATEX* HSound::GetFormat()

{

return &m_wfData;

}

در متد سازندهی این کلاس به طور پیشفرض برای نمونهی صوتی مورد نظر نرخ نمونهبرداری ۴۴.۱کیلوهرتز با ۱۶ بیت در هر نمونه در نظر گرفته شده و فرض بر آن است که نمونهی صوتی یک کاناله است:

HSound::HSound()

{

m_wfData.wFormatTag = WAVE_FORMAT_PCM;

m_wfData.cbSize = 0;

SetBitsPerSample(16);

SetSamplesPerSecond(44100);

SetNumberOfChannels(1);

}

همچنانکه از روی تعریف کلاس قابل فهم است این کلاس در واقع تمامی اعمال را روی عضو دادهی محافظت شدهی m_wfData اِعمال مینماید و با غیر مستقیم نمودن دسترسی به این عضو داده برای برنامهی استفاده کننده ضمن رعایت اصل پنهانسازی اطلاعات به فراخوانی رویهی Update در متدهای تغییر دهندهی اعضای مرتبط با nBlockAlign و nAvgBytesPerSec تغییرات لازم را به آنها اعمال میکند.

2-4-2- انجام پردازش صدا به صورت یک رشتهی مستقل

میتوان با استفاده از توابع کار با صدای ویندوز به گونهای برنامهنویسی نمود که نیازی به ایجاد رشتههای مستقل برای پردازندههای صدا نباشد، اما وجود دلایلی از قبیل عدم انعطافپذیری این روش و تکوظیفهای شدن برنامه در حین انجام عملیات پردازش صدا باعث میشود که روش استفاده از رشتههای مستقل مورد توجه ما قرار گیرد.

از آغاز در نظر داشتیم که رابط برنامه به گونه طراحی شود که کاربر در هنگام کار با برنامه و انجام عملیاتی نظیر ضبط صدا از عملکرد برنامه مطمئن باشد. به این معنی که مثلاً در حین هنگام صدا با استفاده از یک رابط گرافیکی مانند یک نمایشگر اسیلوسکوپی از این که برنامه واقعاً و به درستی در حال ضبط صدای اوست و یا به لحاظ فاصلهی نامتناسب با میکروفن یا عدم اتصال درست آن به کارت صوتی یا خرابی آن بیشتر آنچه ضبط میشود سکوت و یا نویز است مطلع گردد. یک روش مناسب برای ایجاد چنین رابطی استفاده از پیام فرستاده شده برای پردازش صدا توسط یک رشته برای فعال شدن یک تابع رسمکنندهی نمودار اسیلوسکوپی است که نیاز به آن دارد که بدون قطع شدن جریان ضبط پردازش دیگری صورت گیرد. به این منظور و با استفاده از کد اولیهای که در منبع شمارهی ۲ به آن اشاره شده کلاسی به نام HSoundRunner را از کلاس HSound اعضای داده و متدهای مرتبط با پردازش صوت و از کلاس ام.اف.سی CwinThread اعضای داده و متدهای لازم برای یک رشته را ارثبری میکند به صورت زیر تعریف نمودیم:

class HSoundRunner:

public CWinThread,

public HSound

{

public:

DECLARE_DYNCREATE(HSoundRunner)

HSoundRunner();

~HSoundRunner();

void SetBufferSize(int nSamples);

int GetBufferSize();

//this metheods should be overriden:

void AddBuffer();

BOOL Start(WAVEFORMATEX* pwfex=NULL);

BOOL Stop();

//for graphical display:

void SetOwner(CWnd* pWnd);

void ClearOwner(COLORREF crBkColor=0×000000);

public:

//{{AFX_VIRTUAL(HSoundRecorder)

public:

virtual BOOL InitInstance();

//}}AFX_VIRTUAL

protected:

DWORD m_dwThreadID;

int m_iBufferSize; // number of samples per each period

int m_nBuffers; //number of buffers remained to be run

int m_nSamples; //number of samples stored

short* m_pSamples; //samples stored

BOOL m_bRunning; //indicated running or not

//if graphical display is intended set this value

CWnd* m_pOwner;

void DrawBuffer(int nSamples, short* pSamples, COLORREF crBkColor=0×000000, COLORREF crLineColor=0×00FF00);

};