توضیحات

Comparing error minimized extreme learning machines and support vector sequential feed-forward neural networks

ترجمه فارسی موضوع مقاله: مقایسه خطای به حداقل رسیده یادگیریهای ماشین شدید و شبکه های عصبی feed-forward متوالی بردار پشتیبان

چکیده:

اخیراً خطای به حداقل رسیده یادگیریهای ماشین شدید (EM-ELMS) بعنوان یک روش ساده و کارآمد برای ساخت شبکه های عصبی feed-forward با یک لایه پشتیبان به صورت متوالی پیشنهاد شده است.

آنها نودههای مخفی تصادفی یک به یک (یا گروه به گروه) را اضافه میکنند و وزنهای خروجی را به صورت افزایشی برای به حداقل رساندن مجموع مربعات خطا در مجموعه آموزش به روز میرسانند.

سایر روشهای بسیار مشابه که همچنین SLFNS به صورت متوالی میسازند قبلاً با این تفاوت اصلی که وزنهای لایه مخفی آنها یک زیرمجموعه از داده در عوض تصادفی بود آنها میباشد، گزارش شده بود.

این روشها بعنوان شبکههای عصبی feed-forward متوالی بردار* مورد مراجعه قرار میگیرند و آنها یک مورد خاص از مقدار تقریبی توالی با روش ضرایب بهینه و فرکانسهای متعامل (SAOCIF) میباشد.

در این مقاله، ابتدا نشان داده شده است که EM-ELMS همچنین میتواند بعنوان یک مورد خاص از SAOCIF در نظر گرفته شود.

به طور خاص EM-ELMS میتواند به آسانی برای آزمایش تعدادی از نامزدهای تصادفی در هر مرحله گسترش یابد و بهترین آنها را انتخاب کند همانطور که SAOCIF اینکار را انجام میدهد.

علاوه بر این، نشان داده میشود که هزینه محاسبات وزنهای لایه خروجی بهینه در EM-ELMS پیشنهادی اصل میتواند بهبود یابد اگر آن توسط یکی که شامل SAOCIF میشود جایگزین شود.

ثانیاً، ما نتایج بک مطالعه تجربی بر روی 15 طبقه بندی محک و 15 مجموعههای داده رگرسیون که EM-ELMS و SV-SFNNS را مقایسه میکند نشان میدهیم که تحت شرایط یکسان برای 2 مدل انجام شده بود.

اگر هر دو مدل هزینه محاسبات (کارآمدی) یکسانی دارند، یک بهبود قابل توجه آماری در عملکرد تعمیم SV-SFNNS در مقابل EM-ELMS در 12 مورد از 20 مورد مسائل محک یافت شده بود.

- معرفی

شبکههای عصبی feed-forward (FNNS) یک روش یادگیری ماشین معروف برای مسائل طبقه بندی و رگرسیون با خواص بسیار جالب میباشند (برای مثال ببینید، **).

بعنوان یک نوع خاص از FNNS شبکههای عصبی feed-forward با تک لایۀ پنهان (SLFNS) نقش مهمی در کاربردهای عملی بازی می کنند.

از آنجائیکه تعداد بهینه از نودهای مخفی وابسته به مشکل و از قبل ناشناخته میباشد، کاربرها اغلب تعداد نودهای مخفی را توسط آزمون و خطا انتخاب میکنند. هنگامی که معماری ثابت باشد، یک الگوریتم یادگیری تکرار شونده مثل نزول گرادیان back-propagation به طور معمول برای تنظیم وزنها در خروجی و لایههای آخر به طور همزمان اعمال میشود.

با این حال مدلهای FNN که شبکه را به صورت متوالی میسازند وجود دارند به طوری که تعداد واحدهای پنهان یک نتیجه از روند یادگیری میباشد نسبت به ثابت بودن در قبل برای یک بازنگری از FNNS سودمند ببنید برای مثال ( و …).

اخیراً خطای به حداقل رسیده یادگیری ماشین شدید (EM-ELMS) به عنوان یک روش مؤثر و ساده برای ساختن SLFNS به صورت متوالی پیشنهاد شده است.

(Feng و …) EM-ELMS یک گسترش افزایشی که قبلاً ارائه شدهاند برای یادگیریهای ماشین شدید (ELMS) میباشد (**).

هر دو روش نودهای مخفی تصادفی را استفاده میکنند و وزنهای خروجی را برای حداقل رساندن مجموع مربعات خطا در مجموعه آموزش توسط حل یک سیستم خطی معادلات پیدا میکنند.

از ویژگیهای خاص EM-ELMS با توجه به ELMS این میباشد که آنها نودهای مخفی تصادفی را یک به یک (یا گروه به گروه) جمع میکنند و وزنهای خروجی در حال افزایش را در یک راه مؤثر با بهرهگیری از مزایای ساخت و افزایش از ماتریس خروجی لایه مخفی که در سیستم خطی وجود دارد به روز میکنند.

دیگر گسترشهای اخیراً ELMS میتواند پیدا شود در Liang . . . . . .

روشهای بسیار مشابهی که همچنین SLFNS به صورت متوالی را میسازد قبلاً گزارش شده است (chen و …) همۀ آنها وزنهای خطی بهینه را از لایۀ خروجی توسط حل سیستم خطی مشابهی پیدا میکنند.

در واقع، ایده اضافه کردن واحدهای مخفی تصادفی قبلاً در تقریب توالی با ضرایب بهینه و فرکانسهای متعامل (SAOCIF) اعلام شده بود (Remero و … …) الگوریتم به عنوان یک استراتژی ممکن مورد استفاده قرار میگیرد و همانطور که نشان داده شده است در Remero و …، راه حل سیستم خطی میتواند به طور کارآمد به لطف ساخت افزایشی از ماتریس خروجی لایه مخفی محاسبه شود.

EM-ELMS و SAOCIF با استراتژی انتخاب تصادفی میتواند به راحتی نشان داده شود که اساساً برابر میباشد.

(See …) همچنین در بخش 3.1 نشان داده میشود که هزینه محاسبه وزن لایه خروجی که در Feng و همکارانش (2009) توضیح داده شده از هزینه مربوط در SAOCIF توضیح داده شده در Remero و … … بزرگتر میباشد.

یکی دیگر از استراتژیهای پیشنهاد شده در Remero و ……. که با SAOCIF مورد استفاده قرار میگیرد گرفتن وزن لایه مخفی بود همیشه به عنوان یک زیرمجموعه از داده (استراتژی ورودی)

در این مورد روش نتیجه معادل با یادگیری حداقل مربعات متعامد (OLSL) میباشد الگوریتم (chen و …) و توسط پیگیری تطبیق هسته با قبل از اتصالات (KMP-prefit) (Vincert به اشتراک گذاشته شد).

همه آنها وزنهای لایه مخفی در میان بردارهای خروجی را انتخاب میکنند، یک ویژگی با ماشینهای بردار پشتیبان (SVMS) و ( …Vapnik) به همین دلیل، این روشها بعنوان شبکه های عصبی feed-forward متوالی بردار پشتیبان (SV-SFNNS) رجوع داده میشوند. (Remero و …)

SV-SFNNS و SVMS بطور تجربی در Remero و ….. مقایسه شده بودند.

** بسیار مشابه پیدا شدند، اگر چه زمانهای محاسباتی برای SVMS کمتر بودند. با توجه به تعداد بردارهای پشتیبان SV-SFNNS مدلها با واحدهای مخفی کمتر از SVMS استاندارد را در محدودۀ یکسان بعنوان SVMS پراکنده (keerthi و …) ساخت.

از سوی دیگر EM-ELMS در Feng و … محاسبه شدند با دیگر الگوریتمهای متوالی یعنی شبکه های تخصیصی منابع (RAN) (**) و حداقل شبکه های تخصیصی منابع (MRAN) (**) و همینطور با ELMS اصل (**).EM-ELMS عملکرد بهتری و زمان آموزش کمتری از RAN و MRAN بدست آوردند و عملکردی مشابه اما زمان آموزشی کمتر از ELMSها را.

این کار یک مقایسه بین EM-ELMS (به عنوان مثال SAOCIF با استراتژی تصادفی) و SV-SFNNS (به عنوان مثال SAOCIF با استراتژی ورودی) را نشان میدهد.

یک مطالعه تجربی بر روی 10 مجموعه داده محک برای مسائل طبقه بندی 10 مجموعه داده محک برای مسائل رگرسیون ارائه شده است که در آن 2 روش در شرایط یکسان با استفاده از نرمافزار یکسان مقایسه میشوند.

از آنجائیکه هر دو روش میتوانند برای داشتن هزینه محاسبات یکسان تنظیم شوند (هر بردار وزن نامزد برای یک واحد مخفی هم همچنین در میان بردارهای ورودی به صورت تصادفی تولید میشود یا بصورت تصادفی انتخاب میشود)، هدف پیدا کردن این است که آیا هیچ اختلافی در تعمیم عملکرد بین EM-ELMS و SV-SFNNS وجود دارد؟

به بیان دیگر آیا استفاده از ورودیها (بردارهای پشتیبان) به عنوان وزنهای واحد مخفی هیچ مزیتی بر انتخاب تصادفی بصورت خالص را فراهم میآورد؟

به طور مستقیم، استراتژی ورودی باید بهتر از نوع تصادفی عمل کند، از آنجائیکه نمونه استراتژی ورودی وزنها از توزیع زمینهای داده شکل میگیرند. این اطلاعات در استراتژی تصادفی نادیده گرفته میشود که خصوصیات آماری داده را نمیپذیرد.

در مقابل، استراتژی تصادفی میتواند سود انعطاف پذیری پالایش را برای کشف مناطق فضای وزنها بدست آورد در حالی که استراتژی ورودی نمیتواند این کار را انجام دهد.

علاقۀ رو به رشد در مدلهایی که بصورت تصادفی وزنهای واحدهای مخفی را انتخاب میکنند (ببییند Feng و همکارانش ………. و منابع آن ) مقایسه استراتژی ورودی و تصادفی را مربوط به هم میسازد.

علاوه بر این باید توجه داشت که از یک سو EM-ELMS برای ساختن SLFNS بعنوان یک جایگزین برتر (به علت سادگی، کارایی و اثر آنها) برای روشهای شبکه عصبی معمولی مثل نزول گرادیان back-propagation (Feng …..) پیشنهاد شده است و از سوی دیگر بردارهای ورودی به ندرت به عنوان وزنهای لایه مخفی در SLFNS به خصوص در مورد واحدهای در حال افزایش (به عنوان مثال perceptronهای دو لایه) استفاده میشوند.

2. سابقه

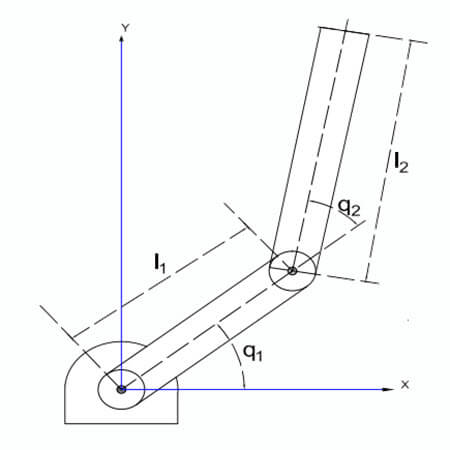

تابع خروجی یک SLFN و به عنوان مثال FNN به طور کامل مرتبط با یک لایه مخفی از واحدهای و m واحد خروجی خطی) میتواند بعنوان یک ترکیب خطی از تابعهای ساده (*) بیان شود:

فرمول 1:…

در جایی که ** و پارامترهای یادگیری از واحدهای مخفی میباشند، وزنهای لایه خروجی متصل به iامین واحد مخفی برای m واحد خروجی میباشد، تابع فعالسازی واحدهای مخفی میباشد، () خروجی iامین واحد مخفی با توجه به x ورودی میباشد و شرایط بایاس (اگر وجود داشته باشد) واحدهای خروجی خطی را بیان میکند.

اگر چه بسیاری از توابع فعال سازی (حتی شبیه نورون نباشد) به قابلیت تقریب جهانی اجازه میدهد میتواند مورد استفاده قرار گیرد، انتخابهای معمول بیشتری RBF گوسین را به کار میگیرند برای یک فاصله بین یک بردار ورودی و یک مرکز.

فرمول 2:…

و سیگموئید (به عنوان مثال تانژانت هایپربولیک) برای یک محصول عددی از ورودی و بردارهای وزن (این اشاره خواهد داشت به یک واحد در حال افزایش سیگموئید (Feng و همکارانش…)) به کار میرود.

فرمول 3:…

برای واحدهای RBF گوسین و مرکز و فاکتور تأثیر از iامین واحد RBF هستند.

برای واحدهای افزایشی بردار سیگموئید بردار وزن متصل به لایه ورودی برای iامین واحد مخفی و بایاس iامین واحد مخفی میباشد.

در تجارب ما که در قسمت 3 نشان داده شده یک تابع فعالسازی درجه سه هم آزمایش شده است، سینوس برای محصول عددی (به عنوان مثال واحد افزایشی سینوس) به کار رفته است.

فرمول 4:…

برای یک مجموعه داده از مثالهای آموزش اگر خروجیهای شبکه مساوی با هدفها باشند، ما داریم:

فرمول 5:…

معادل 5 بصورت فشرده بصورت زیر میتواند نوشته شود:

فرمول 6:…

که در آن H یک ماتریس میباشد که ماتریس خروجی لایه مخفی از شبکه نامیده میشود ()، یک ماتریس شامل وزنهای لایه خروجی میباشد و T یک ماتریس شامل مقادیر هدف در مجموعه آموزش میباشد.

بایاس لایه خروجی میتوانند با در اضافه شوند با اولین ستون با یک مقدار ثابت 1 و با H اضافه شوند با * اولین ستون با یک مقدار ثابت 1 (و با افزایش با 1).

به طور معمول تعداد مثالهای آموزش L خیلی بیشتر از تعداد واحدهای مخفی خواهد شد و یک راه حل دقیق از معادلۀ 6 نمیتوان انتظار داشت. پس تابع هزینه معمول در SLFNS (و به طورکلی در FNNS) مجموع مربعات خطا میباشد.

فرمول 7:…

معروف است که (به عنوان مثال …..) برای به حداقل رساندن E، وزنهای لایه خروجی بهینه میتوانند محاسبه شوند به شکل زیر

فرمول 8:…

که معکوس pseude (یا معکوس تعمیم داده شدۀ Moorcperrose) از خروجی لایه مخفی ماتریس H میباشد.

مجموع مربعات خطا میتواند در شکل زیر بیان شود.

فرمول 9:…

2.1 خطای به حداقل رسانده شده یادگیری ماشین شدید (EM-ELMS)

Huang و …… نشان دادهاند که SLFNS با وزنهای تصادفی در لایه مخفی قابلیت تقریب جهانی برای انتخابهای بسیار متفاوتی از تابع فعالسازی شامل آنکه در معادله (4)- (2) ذکر شد دارند.

بر پایه این نتایج آنها الگوریتم یادگیری ELMS (Huang …… ) را پیشنهاد میکنند که به صورت زیر خلاصه میشود:

الگوریتم برای ELMS با توجه به مجموعه مثالهای آموزش تابع فعالسازی لایه مخفی و یک عدد ثابت اولیه از واحدهای مخفی.

1) به طور تصادفی پارامترهای واحد مخفی را تعیین کنید.

2) خروجی لایه مخفی ماتریس H را محاسبه نمائید.

3) وزن لایه خروجی ماتریس استفاده شده در معادلۀ 8 را محاسبه نمائید.

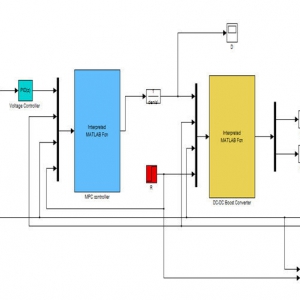

به منظور اجتناب از نیاز به تنظیم در پیشبرد تعداد از واحدهای مخفی و کاهش زمان محاسبات آموزش یک گسترش متوالی سریع از الگوریتم ELMS بنام EM-ELMS به تازگی توسط Feng …….. گزارش شده است. EM-ELMS در شکل 1 شرح داده شده است.

در آزمایشات گزارش داده شده هم ELMS و هم EM-ELMS، مقادیر تصادفی برای وزنها از توزیع یکنواخت را نمونه برداری کردند.

2.2 تقریب متوالی با ضرایب بهینه و فرکانس متعامل (SAOCIF)

یک روش سازنده به طور نسبی کلی برای SLFNS بنام SAOCIF در Remero …… پیشنهاد شد.

ویژگیهای خاص از SAOCIF این موارد میباشد:

(i) وزنهای لایه خروجی بهینه (در یک مفهوم مربعات حداقل) هر زمان مجدداً محاسبه میشود یک واحد مخفی با حل یک سیستم معادله خطی اضافه میشود و (ii) واحد مخفی اضافه شده در میان یک مجموعه از نامزدها انتخاب میشود و تعاملاتش با واحدهای مخفی اضافه شده قبلی حساب میگردد (به عنوان مثال به حداقل رساندن با هم خطای آموزش).

الگوریتم SAOCIF در شکل 2 توضیح داده میشود.

توجه داشته باشید که اگر ما قرار میدهیم و نامزدها با یک استراتژی تصادفی تولید میشوند آنگاه شرح دقیق نتایج SAOCIF لزوماً معادل با EM-ELMS با (برای همه Kها) میشود.

در این مورد N در SAOCIF معادل با هم K و هم در EM-ELMS میشود.

ممکن است مورد بحث قرار گیرد که EM-ELMS نودهای مخفی را یکی پس از دیگری ( ….) یا یک گروه پس از گروه دیگر اضافه میکند در حالیکه SAOCIF در هنگام اضافه کردن گروه را ذکر نمیکند.

اگر چه این وضعیت قبلی به طور قطع صحیح میباشد، واضح است که در فرمول EM-ELMS اصل اضافه کردن یک گروه از ها واحدهای مخفی به طور کامل معادل با افزایشهای ها از یک واحد مخفی میباشد.

دلیل این موضوع اینست که EM-ELMS فقط یک نامزد () را برای هر واحد مخفی انتخاب میکند.

به هر حال، اگر چندین نامزد از هر واحد مخفی امکانپذیر باشد (، چیزی که EM-ELMS پیشبینی نمیکند) آنگاه واضح است که افزایشات یکی پس از دیگری و گروه بعد از گروه دیگر معادل نمیباشند.

به هر حال، کاملاً آشکار است که SAOCIF ممکن است برای افزایش گروه کار کند (ببینید قسمت 3.1) به همان روشی که EM-ELMS کار میکند.

2.3 شبکه های عصبی feed-forward متوالی بردار پشتیبان (SV-SFNNS)

جدا از استراتژی تصادفی در روش SAOCIF امکانات دیگری برای تولید نامزدها موجود میباشد.

به طور خاص، اجازه دهید ما استراتژی ورودی را تعریف کنیم به عنوان یکی که در آن نامزدها فقط در میان مثالهای ورودی در مجموعه آموزش انتخاب میشوند، با دقت بیشتری برای برخی jها که قبلاً استفاده نشده و b یک مقدار ثابت وابسته به تابع فعالسازی میباشد (به عنوان مثال 1= b برای واحدهای RBF و 0= b برای واحدهای افزایشی).

سپس ما قرار بدهیم و نامزدها با استفاده از استراتژی ورودی تولید میشوند، روش نتیجه بهترین مثالهای ورودی را به عنوان وزنهای لایه مخفی از واحد مخفی جدید انتخاب میشوند.

این روش که SV-SFNNS نامیده میشود (Romero. ……) معادل با الگوریتم OLSL(chen و …) و با KMP-perfit (Vincent ……) میباشد.

در واقع، OLSL فقط برای واحدهای RBF و KMP-perfit برای توابع فعالسازی مبتنی بر هسته پیشنهاد شده بود در حالیکه SAOCIF با استراتژی ورودی به مانند هر تابع فعالسازی دیگری با قابلیتهای تقریب جهانی (به عنوان مثال، واحدهای افزایشی سینوسی) مجوز صادر میکند.

- انجام پروژه شبکه عصبی با متلبی

3. مقایسه EM-ELMS و SV-SFNNS

این قسمت EM-ELMS را با SV-SFNNS مقایسه میکند و متدولوژی تشریح شده در آزمایشات را توضیح میدهد.

3.1 تجریه و تحلیل هزینه محاسبات

پیچیدگی محاسبات الگوریتم برای EM-ELMS توسط محاسبه و است که شامل مراحل متوسط، محاسبه ماتریسهای L×L که از لحاظ زمان و حافظه هزینه بردار میباشد.

از آنجائیکه L بصورت نرمال خیلی بزرگتر از خواهد بود و با فرض اینکه هزینه محاسبات برای بدست آوردن و خواهد بود () **به هر حال، این محاسبه میتواند با هزینه محاسباتی کمتری انجام شود همانطور که در آینده توضیح داده میشود.

فرمول 10:…

فرمول 11:…

آن یک تعمیم دهی (برای خروجیهای m و اضافه کردن واحدهای مخفی ما در مرحله مشابهی) از روش افزایشی شرح داده شده در Romero و ….. برای اضافه کردن یک واحد مخفی میباشد.

برای چک کردن این به سادگی در فرمول 10 به جای U و Y **و به جای V، a و به جای ، b را جایگزین کنید در اینصورت معادله 6 در Romero و ….. بدست خواهد آمد. محاسبه معادله 10 و 11 سریعتر از الگوریتمهای اصلی برای EM-ELMS میباشد زیرا هزینه محاسباتی آن **میباشد.

بنابراین، اگر چه هزینه محاسباتی الگوریتمهای اصلی EM-ELMS و SV-SFNNS یکسان نمیباشد اما آنها میتوانند به سادگی معادل را در نظر گرفته شوند.

برای ، A میتواند برای نامزدی اول محاسبه شود و در حافظه ذخیره شود و برای بقیه نامزدها بهبود یابد.

بنابراین هزینه محاسباتی برای کمتر از دفعه هزینه محاسباتی برای میباشد. با دقت بیشتر با این بهینه سازی، هزینه محاسباتی از اولین تکرار حلقه داخلی از SAOCIF، ()0 و برای بقیه تکرارها میباشد.

3.2 روشهای مقایسه شده و تنظیمات

در ابتدا، الگوریتمهای اصلی برای EM-ELMS و SV-SFNNS فقط میتواند مستقیماً محاسبه شود اگر ما را تنظیم کنیم، فقط به خاطر اینکه در EM-ELMS حلقه داخلی SV-SFNNS (در حالیکه ) انجام نشده است.

به هر حال انتخاب محدود به انعطاف پذیری SV-SFNNS میشود. از آنجائیکه هدف این مقاله ایجاد یک مقایسه کلی بین استراتژیهای ورودی و تصادفی میباشد، 2 تنظیم تعریف شده است.

در اولی میباشد، به طوریکه EM-ELMS اصل با یک نسخه خیلی محدود شده از SV-SFNNS روبرو میشود در شرایطی که فقط یک ورودی انتخاب شده تصادفی (نه بهترینش) منجر به نامزدی واحد میگردد.

در دومی میباشد، بطوریکه یک نسخه توسعه یافته از EM-ELMS (با ارتقاء انتخاب بهترین نامزد تصادفی در میان ها در هر مرحله) با یک نسخه به چندان محدود از SV-SFNNS مواجه میشود در شرایطی که نه بهترین نامزدهای باقی مانده که بهترین از یک زیر مجموعه انتخاب شده تصادفی (از لحاظ اندازه ) اضافه میشود.

انتخاب توجیه میشود زیرا به منظور دست یافتن به یک نامزد با احتمال 95% در میان 5% از همه نامزدها یک زیرمجموعه تصادفی از اندازه []=59 کافی میباشد (Smola و …..)

برای هر تنظیم، تنها تفاوت اینطور بدست میآید که آیا نامزدها بصورت تصادفی بدست آمده اند یا بصورت تصادفی از الگوهای ورودی گرفته شدهاند. این تنظیمات اجازه به ساختن یک مقایسه عادلانه از EM-ELMS و SV-SFNNS میدهد، از آنجائیکه آنها در شرایط یکسانی کار میکنند و زمان محاسباتی مشابهی نیز دارند.

3.3 نرم افزار

ما اجرای خودمان را در تنظیم C استفاده کردهایم با پارامترهای الگوریتم همانطور در پاراگراف قبل توضیح داده شد. وزنهای لایه خروجی بهینه با استفاده از معادله 10 و 11 محاسبه شد.

3.4 مجموعه های داده

مقایسه با استفاده از 20 مجموعه داده محک اجرا شد، 10 برای مسائل طبقهبندی و 10 برای مسائل رگرسیون مجموعههای داده طبقهبندی ……… بودند و میتوانند در مخزن UCI(Asunc** و ……) پیدا شوند.

ویژگیهای این مجموعه داده در جدول 1 خلاصه شده است. مجموعههای داده رگرسیون ………. بودند که میتوانند در ……و http پیدا شوند. ویژگیهای این مجموعه داده در جدول 2 خلاصه شده است.

3.5 متدولوژی (روش شناسی)

پیش پردازش: ویژگیهای طبقهای به متغیرهای ساختگی تبدیل شد (P طبقهبندی مختلف با P متغیر ورودی نشان داده شد، بطوریکه فقط متغیر ورودی مربوط به طبقهاش یک میباشد و بقیه صفر هستند). بقیه ویژگیهای (شامل متغیر هدف برای مجموعههای داده رگرسیون) مدرج شدند به معنی صفر و واریانس یک.

وزنهای تصادفی: در استراتژی تصادفی، وزنهای لایه مخفی بطور یکنواخت با طیف مشابهی از مقادیر انتخاب شدند که مقادیر ورودی انتخاب شده بودند (بعد از مقیاسگذاری) در این راه، طیفهای وزنهای لایه مخفی برای هر دو استراتژی مشابه بود.

توابع فعالسازی: 3 نوع مورد استفاده قرار گرفت. گوسین RBF (2)، سیگموئید افزایشی (3) و واحدهای سینوسی افزایشی (4) اما با یک ضربشونده بیشتر، پارامتر مثبت برای یک تحقیق گستردهتر معرفی شد. به طور خاص، ضرب کند فاصله در واحدهای RBF و تولید عددی در واحدهای افزایشی را.

پارامترها و انتخاب مدل: یک بردار وزن نامزد واحد مخفی معتبر در نظر گرفته نمیشد اگر سیستم معادلات خطی مرتبط نمیتوانستند حل شوند یا اگر 1 نورم از راهحل (وزنهای لایه خروجی) بزرگتر از یک مقدار قطعی M بود. این به عنوان یک شکل نظم دهی میتواند دیده شود.

M به مقدار 1024 تنظیم شد ما ثابت کردیم و بطوریکه واحدهای مخفی همیشه اضافه میشوند.

این مقادیر بر طبق تجربه قبلی ما با این مدلها انتخاب شد به یاد بیاورید که هدف از آزمایشات مقایسه EM-ELMS و SV-SFNNS تحت شرایط یکسان برای دو مدل میباشد).

به منظور دریافت یک مقدار مناسب برای پارامتر در مسائل وابسته خیلی بیشتری، یک تحقیق در محدودۀ از 10-2 به 25 انجام شد. تحقیق مشابهی برای همه مدلها انجام و برای هر تابع فعالسازی تکرار شد.

آموزش و آزمایش مدل: روشهایی که بیش از 30 تست اعتبار آموزش پارتیشنهای تصادفی مختلف (** آموزش، 10% اعتبار، 10% تست) از همه مجموعه داده را آموزش و تست داده شدند.

برای هر تنظیم (تعریف شده با یک استراتژی داده شده، ، تابع فعالسازی و ) شبکههای با کمترین خطاها در زیر مجموعه های معتبر بعنوان مدلهای نهایی انتخاب شدند. برای مجموعههای داده طبقهبندی، دقت مدلهای نهایی توسط دقتهای میانگین اندازهگیری شد.

در زیرمجموعههای تست داده شده بود. برای مجموعههای داده رگرسیون، عملکرد مدلهای نهایی توسط نرمال شده مربعات خطا (NSE) که در زیر آمده است اندازهگیری شد. (Bishop و ……)

از آنجائیکه K تعداد مثالهای در مجموعه تست میباشد، F(x) مدل نهایی و t مقدار متوسط هدف در مجموعه تست میباشد.

اندازه مدلهای نهایی توسط تعداد میانگین آنها از واحدهای مخفی تعریف میشوند.

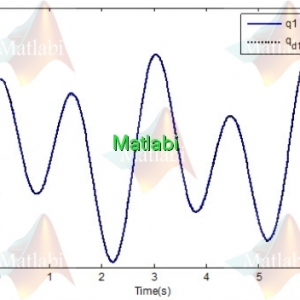

3.6 نتایج تجربی

جدول 3 و 4 دقتهای میانگین از بهترین مدلهای نهایی (در میان همه ها) برای 2 استراتژی (ورودی و تصادفی) و 3 تابع فعالسازی امتحان شده (RBF گوسین، افزایشی سینوسی و افزایشی سیگموئید) با استفاده از متدولوژی قبلی توضیح داده شده، برای 10 مجموعه داده طبقه بندی مطالعه شده را نشان میدهد.

جدول 3 نتایج روشها برای را نشان میدهد که در آن استراتژی ورودی به طور کامل قابل مقایسه با EM-ELMS میباشد و جدول 4 نتایج برای را نشان میدهد. برای 10 مجموعههای داده رگررسیون مطالعه شده، جداول 5 و 6 میانگین NSE از بهترین مدلهای نهایی برای و را نشان میدهند.

جداول 10-7 میانگین تعداد واحدهای مخفی در مدلهای نهایی انتخاب شده برای هر ترکیب از استراتژی و تابع فعالسازی برای و را نشان میدهند.

قابل مشاهده است که مجموعه های داده Iris و Wine متناظر با مسائل ساده میباشند که بطور کامل با استفاده از هر دو استراتژی آموزش دیده اند.

برای مجموعههای داده دیگر نتایج تست بین دو استراتژی در برخی موارد مشابه به نظر میرسد و یک عملکرد برتر از استراتژی ورودی میتواند در ادامه مورد توجه قرار گیرد به جز برای مجموعه داده Stock.

جای تعجب نیست که بهترین مقادیر برای هر استراتژی و مجموعه داده در جدول 4 و 6 آمدهاند (به عنوان مثال، آنها بدست آمدهاند با استفاده از )

البته دوباره به جز برای مجموعه Stock. توجه داشته باشید که تعداد کم واحدهای مخفی از بهترین مدلهای نهایی برای مجموعه داده Stock (ببینید جدول 9 و 10 را) یک شاخص واضح از یک گرایش قوی به Overfitting در این مجموعه داده میباشد.

اگر ما ادعا نمیکنیم که نتایج ما برای مجموعههای داده تست شده بهینه میباشد، آنها با نتایج روشهای بهترین دیگر رقابت میکنند (ببینید برای مثال Van Gestel و همکارانش را در سال 2004 برای مجموعههای داده طبقهبندی و Ting و Zhou **در سال 2007 برای مجموعههای داده رگرسیون را).

به منظور دستیابی به یک اندازهگیری آماری هدفمند یک t-test دانشآموزی برای هر مجموعه داده به کار برده شد تا اختلاف بین بهترین نتایج میانگین از 2 استراتژی که از نظر آماری با اهمیت بود را بررسی کند ( P-Value=0/05 به عنوان مثال اعتماد به نفس 95%).

آزمونی که برای بدست آوردن بهترین مدلها با به کار رفته بود، در شکل bold مشخص شده است (همه آنها بهترین نتایج برای هر استراتژی و مجموعه داده میباشند به جز برای مجموعه داده Stock).

نتایج برای تست در جدول 11 نشان داده شده است.

در 6 مجموعه داده طبقهبندی (Austra lina و …..) و 6 مجموعه داده رگرسیون (Auto و ……..) t-test یک اختلاف با اهمیت با یک دقت میانگین برتر از استراتژی ورودی داده است در حالی که هیچ اختلاف قابل توجهی در آنها دیگر یافت نشد (German و ……..).

اختلافهای کوچک (ببینید Gene و ……. برای مثال) گاهی اوقات خیلی با اهمیتتر از آنهایی که بزرگ هستند میباشد (Stock برای مثال) زیرا اولی دارای واریانسهای خیلی کوچک میباشد.

اگر چه هیچ روند روشنی درباره تعداد واحدهای مخفی انتخاب شده توسط هر دو استراتژی مشاهده نشده است (آن بستگی کامل به تابع فعالسازی خاص دارد)، استراتژی ورودی به نظر میرسد نیاز به واحدهای بیشتر از استراتژی تصادفی در مورد واحدهای مخفی RBF گوسین داشته باشد (به آسانی در جدول **دیده میشود).

با توجه به تعداد نامزد** مدلهای نهایی بدست آورده شده با به طور معمول واحدهای مخفی بیشتری از آنهایی که با بدست آورده شده دارند. بعنوان یک مرجع، زمانهای اجرای متوسط برای دستیابی به هر مدل نهایی 58.8 ثانیه برای Satimsge و 99 ثانیه برای Census House بوده است (انجام شده در یک نود از یک خوشه محاسبات با در 2.66 گیگاهرتز).

3.7 بحث

دلایل متعددی وجود دارد که میتواند توضیح دهد چرا عملکرد استراتژی ورودی از نوع تصادفی آن بهتر میباشد، که در آینده توضیح داده میشود. از یک طرف دیگر، اصل به حداقل رساندن ریسک ساختاری یک عدم داد و ستد بین کیفیت تقریب برای داده و پیچیدگی مدل را تعریف میکند (1995, Vapnik).

برطبق این اصل با توجه به دو مدل با همان ریسک تجربی، مدل با پیچیدگی کمتر (قابلیت تقریب) باید ترجیح داده شود.

در آزمایشهای ما اختلافی بین ریسکهای تجربی * از استراتژیهای ورودی و تصادفی مشاهده نشد، هر چند واضح است که استراتژی تصادفی قابلیت تقریب بیشتری از نوع ورودی آن دارد.

از سوی دیگر، انتخاب وزنهای لایه مخفی بین بردارهای ورودی احتمال بیشتری برای به دست آوردن نامزدهای بهتری (در شکل نامزدهای آموزنده، مثل proto types، border points و غیره) از نمونهبرداری آن بصورت تصادفی دارد.

از بعضی جهات، انتخاب وزنهای لایه مخفی بین بردارهای ورودی مرتبط با نمونهبرداری توزیع زمینهای میباشد.

4. نتایج و کارآینده

ابتدا نشان داده شده است که EM-ELMS میتوانند بعنوان یک مورد خاص از روش SAOCIF (با استراتژی تصادفی) برای ساخت SLFNS در نظر گرفت.

تنها دو تفاوت واقعی بین EM-ELMS واقعی پیشنهاد شده در Feng و همکارانش در سال 2004 و روش SAOCIF با استراتژی تصادفی پیشنهاد شده در Remero و Alquezar در سال 2006 این موارد میباشند:

(i) روش افزایشی که وزنهای لایه خروجی بهینه مشابه (در حداقل شکل مربعات) هر زمان مجدداً محاسبه میشوند و یک واحد مخفی،

اضافه میشود (یا تست میشود) و

(ii) تعداد نامزدهای تصادفی برای هر واحد مخفی تست میشود.

با توجه به اولین تفاوت، در قسمت 3.1 نشان داده شده است که هزینه محاسبات توصیف شده در Feng و همکارانش در سال 2004 بیشتر از متناظر آن در روش توصیف شده (تعمیم شده) در Remero و Alquezar در سال 2006 میباشد.

از آنجائیکه هر دو روش وزنهای لایه خروجی بهینه مشابه را محاسبه میکنند، هیچ مشکلی در استفاده کارآمدی بیشتری آنها همچنین برای EM-ELMS برای از بین بردن تفاوت وجود ندارد.

تفاوت دوم همچنین میتواند هم با محدود کردن SAOCIF برای تست یک نامزد واحد در هر مرحله (همانطور که EM-ELMS اصل انجام میدهد) یا با گسترش EM-ELMS برای تست تعدادی از نامزدهای تصادفی در هر مرحله و انتخاب بهترین آنها (همانطور که SAOCIF انجام میدهد) حذف شود.

هر دوی احتمالات در نتایج تجربی که در این مقاله انجام شدهاند مورد بررسی قرار گرفتهاند.

ظاهراً تفاوت سوم بین الگوریتم EM-ELMS و SAOCIF با استراتژی تصادفی اینست که اولی اجازۀ افزایش گروه به گروه از واحدهای مخفی را میدهد در حالیکه دومی این اجازه را نمیدهد.

به هر حال، این یک تفاوت واقعی نیست زیرا هنگامی که یک نامزد تصادفی واحد برای هر واحد مخفی استفاده میشود اضافه کردن یک گروه از N واحد مخفی به طور کامل معادل با N افزایش از هر واحد مخفی میباشد و SAOCIF ممکن است همچنین افزایش گروهی را انجام دهد در راهی مشابه که EM-ELMS انجام میدهد.

توجه داشته باشید که اگر به چندین نامزد هر واحد مخفی اجازه داده شود (چیزی که EM-ELMS پیشبینی نمیکند) آنگاه افزایش یکی بعد از دیگری و گروه بعد از گروه دیگر معادل نمیباشد. ما اثبات میکنیم که اجازه دادن به چندین نامزد هم واحد برای افزایش یکی پس از دیگری خیلی با اهمیتتر میباشد نسبت به اضافه کردن واحدهای تنها نامزد گروه بعد از گروه دیگر.

ثانیاً، ما ادعا کردهایم که یک روش متوالی جایگزین برای ساخت SLFNS میتوان بر پایۀ انتخاب وزنهای لایه مخفی در میان بردارهای ورودی در مجموعه آموزش بنا نهاد.

این روش، که به آن به عنوان SV-SFNNS (Remero و …….) یا SAOCIF با استراتژی ورودی (Remero و ……) اشاره شده است، لزوماً معادل با الگوریتم OLSL و KMP-Prefit میباشد.

به منظور ارزیابی عملکرد نسبی هر دو روش (EM-ELMS در مقابل SV-SFNNS) به شیوهای عادلانه، یک مطالعه تجربی در 20 مجموعه داده محک تشخیص داده شده است، 10 برای طبقهبندی و 10 برای رگرسیون تحت شرایط یکسان و با استفاده از نرم افزار یکسان.

مقایسه تجربی بین EM-ELMS و SV-SFNNS ارائه شده در مقاله دو نتیجه گیری جالب را به تصویر میکشد که میتواند در تحقیقات آینده بیشتر مورد بررسی قرار گیرد.

ابتداعاً این میباشد که انتخاب وزنهای لایه مخفی بعنوان یک زیرمجموعه از داده ورودی، حتی اگر این انتخاب به صورت تصادفی انجام شود، منجر به نتایج تعمیمدهی بیشتری نسبت به انتخاب وزنهای لایه مخفی در یک روش از ابتدا صرفاً تصادفی میشود (همانطور که EM-ELMS انجام میدهد).

همانطور که در انتهای قسمت 1 بحث شد این یک نتیجه بدیهی نمیباشد.

در حقیقت، هیچ اختلاف با اهمیت آماری بین میانگین عملکردهای بدست آمده توسط دو استراتژی در هشت مسائل محک پیدا نشد، اما SV-SFNNS یک بهبود با اهمیت آماری در عملکرد تعمیدهی را در دوازدهتای دیگر نشان داد.

ممکن است پرسیده شود که آیا هیچ اختلاف قابل توجهی بین این دو گروه از مسائل وجود دارد.

برای مسائل طبقه بندی، مجموعه های داده با یک تعداد بیشتری از متغیرها (جدول 1 را ببینید و تصور کنید برای مثال یک آستانه دلبخواهی از 20 ورودی را) آنهایی بودند که در SV-SFNNS عملکرد بهتری نسبت به EM-ELMS داشتند (به جزSeymentation problems , German).

اگر چه این میتواند بعنوان یک نتیجه معقول در نظر گرفته شود، که ممکن توسط مشکل در پیدا کردن مرزهای تصمیمگیری مناسب در فضاهای ورودی با ابعاد بالا از وزنهای لایه مخفی توزیع شده تصادفی توجیه شود، فرضیه زمینه نیاز به اعتبار بیشتر در مطالعات آینده دارد.

برای مسائل رگرسیون این روند چندان روشن نیست. نتیجه دوم مطالعه تجربی این است که مستقل از استراتژی استفاده شده (ورودی یا تصادفی) تعداد نامزدها برای وزنهای لایه مخفی، یک پارامتر میباشد که کنترل عدم داد و ستد بین عملکرد تعمیمدهی، هزینه محاسباتی و تعداد واحدهای مخفی از مدلهای نهایی را به عهده دارد.

به طور کلی، با افزایش تعداد نامزدها در هر مرحله از الگوریتم متوالی (به یاد بیاورید که در EM-ELMS پیشنهادی اصل این تعداد 1 میباشد)، تعمیمدهی بهبود مییابد و تعداد نهایی واحدهای مخفی کاهش مییابد، در بهای یک زمان آموزش بیشتر، به هر حال همانطور که در بخش 3.1 اشاره شد هزینه محاسباتی از نامزدهای در حال اجرای C کمتر از C دفعه هزینه یک نامزد تنها در حال اجرا میباشد، با توجه به راه افزایشی که در آن وزنهای لایه خروجی بهینه محاسبه میشوند.

هر دو استراتژی میتواند بیشتر بهبود یابد. استراتژی تصادفی میتواند اصلاح شود به طوریکه برای دستیابی به وزن که در محاسبات وارد میشوند از توزیع زمینهای داده استفاده شد** ورودی 1 میتواند** روشهای انتخاب نمونه را (ببینید……..) برای انتخاب بردارهای ورودی در یک راه بهتر نسبت به صورت تصادفی بدست آورد.

علاوه بر این، تکنیکهای نظمدهی همچنین میتوانند برای هر دو استراتژی استفاده شوند.

نتیجه خروجی مربوط به شبیه سازی با متلب این محصول:

>> main

Average number of hidden units for regression data sets—best of 59 candidates.

———————————————————————-

Gossian RBF Sigmoid MLP Sine MLP

————————————————–

input rand input rand input rand

—– —- —– —- —– —-

47 35 60 57 42 53

Comparison of average test NSE for regression data sets—best of 59 candidates.

———————————————————————-

Gossian RBF Sigmoid MLP Sine MLP

————————————————–

input rand input rand input rand

—– —- —– —- —– —-

0.10034 0.43679 0.20812 0.44468 0.062186 0.45669

>>

کلید واژه : شبکه های عصبی

Error minimized extreme learning, machines, Support vector sequential feed-forward, neural networks, Sequential approximations

شبیه سازی مقاله Comparing error minimized extreme learning machines and support vector sequential feed-forward neural networks

به تعداد محدودی قابل فروش می باشد.

سفارش انجام پروژه مشابه

درصورتیکه این محصول دقیقا مطابق خواسته شما نمی باشد،. با کلیک بر روی کلید زیر پروژه دلخواه خود را سفارش دهید.

دیدگاهها

هیچ دیدگاهی برای این محصول نوشته نشده است.